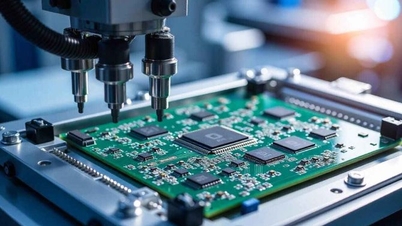

Programme für künstliche Intelligenz haben in den letzten Jahren viele Erfolge erzielt – Foto: REUTERS

Wir können nicht den gesamten Prozess von den Eingabedaten bis zu den Ausgabeergebnissen großer Sprachmodelle (LLMs) beobachten.

Um die Funktionsweise dieser Programme verständlicher zu machen, verwenden Wissenschaftler gängige Begriffe wie „Argumentation“. Sie sagen auch, dass die Programme wie Menschen „denken“, „schlussfolgern“ und „verstehen“ können.

Übertreibung der Fähigkeiten der KI

Laut ZDNET vom 6. September haben in den vergangenen zwei Jahren viele KI-Führungskräfte zu Übertreibungen gegriffen, um einfache technische Errungenschaften zu übertreiben.

Im September 2024 gab OpenAI bekannt, dass das o1-Argumentationsmodell „bei der Problemlösung eine Schlussfolgerungskette verwendet, ähnlich der Art und Weise, wie Menschen lange nachdenken, wenn sie mit schwierigen Fragen konfrontiert werden.“

KI-Wissenschaftler widersprechen jedoch: Sie glauben, dass KI nicht über die menschliche Intelligenz verfügt.

Eine Studie einer Autorengruppe der Arizona State University (USA) über die Datenbank arXiv hat die Denkfähigkeit von KI mit einem einfachen Experiment bestätigt.

Die Ergebnisse zeigten, dass „Schlussfolgerungen durch Gedankenketten eine fragile Illusion“ sind und kein echter logischer Mechanismus, sondern lediglich eine ausgeklügelte Form des Musterabgleichs.

Der Begriff „Gedankenkette“ (CoT) ermöglicht es der KI, nicht nur eine endgültige Antwort zu finden, sondern auch jeden Schritt der logischen Argumentation darzustellen, wie in den Modellen GPT-o1 oder DeepSeek V1.

Illustration des GPT-2-Sprachmodells von OpenAI – Foto: ECHOCRAFTAI

Sehen Sie sich an, was KI tatsächlich leistet

Umfangreiche Analysen zeigten, dass sich LLM eher auf Semantik und oberflächliche Hinweise als auf logische Denkprozesse verlasse, sagen die Forscher.

„LLM konstruiert oberflächliche logische Ketten auf der Grundlage erlernter Eingabeassoziationen und scheitert häufig bei Aufgaben, die von herkömmlichen Denkmethoden oder bekannten Mustern abweichen“, erklärt das Team.

Um die Hypothese zu testen, dass LLM lediglich Mustervergleich und nicht tatsächlich Schlussfolgerungen sind, trainierte das Team GPT-2, ein Open-Source-Modell, das 2019 von OpenAI veröffentlicht wurde.

Das Modell wurde zunächst anhand sehr einfacher Aufgaben mit den 26 englischen Buchstaben trainiert, etwa mit der Umkehrung einiger Buchstaben, beispielsweise „APPLE“ in „EAPPL“. Anschließend änderte das Team die Aufgabe und bat GPT-2, sie zu übernehmen.

Die Ergebnisse zeigen, dass GPT-2 Aufgaben, die nicht in den Trainingsdaten enthalten sind, mit CoT nicht genau lösen kann.

Stattdessen versucht das Modell, die ähnlichsten erlernten Aufgaben anzuwenden. Seine „Schlussfolgerungen“ klingen also vernünftig, die Ergebnisse sind jedoch oft falsch.

Die Gruppe kam zu dem Schluss, dass man sich nicht zu sehr auf die Antworten des LLM verlassen oder ihnen blind vertrauen sollte, da diese „Unsinn produzieren können, der sehr überzeugend klingt“.

Sie betonten außerdem, dass man die wahre Natur der KI verstehen müsse, Hype vermeiden und nicht mehr behaupten müsse, dass KI die Fähigkeit habe, wie Menschen zu denken.

Quelle: https://tuoitre.vn/nghien-cuu-moi-ai-khong-suy-luan-nhu-con-nguoi-20250907152120294.htm

![[Foto] Das Politbüro arbeitet mit den Ständigen Ausschüssen der Provinzparteikomitees von Vinh Long und Thai Nguyen zusammen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/8/4f046c454726499e830b662497ea1893)

![[Foto] Das Politbüro arbeitet mit den Ständigen Ausschüssen der Parteikomitees der Provinzen Dong Thap und Quang Tri zusammen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/8/3e1c690a190746faa2d4651ac6ddd01a)

![[Foto] Erstaunliche totale Mondfinsternis an vielen Orten der Welt](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/8/7f695f794f1849639ff82b64909a6e3d)

Kommentar (0)