(CLO) Das Spracherkennungstool Whisper von OpenAI wird als „nahezu robust und präzise wie ein Mensch“ beworben, hat aber einen großen Nachteil: Es neigt dazu, Textausschnitte oder sogar ganze Sätze zu erfinden!

Einige der von ihm erfundenen Texte, die in der Branche als halluzinatorisch gelten, können rassistische Kommentare, Gewalt und sogar imaginäre medizinische Behandlungen enthalten, sagen Experten.

Experten halten solche Fälschungen für schwerwiegend, da Whisper in vielen Branchen weltweit zum Übersetzen und Transkribieren von Interviews sowie zum Erstellen von Texten und Untertiteln für Videos verwendet wird.

Noch beunruhigender ist, dass medizinische Zentren Whisper-basierte Tools verwenden, um Arzt-Patienten-Konsultationen aufzuzeichnen, obwohl OpenAI davor warnt, das Tool in „Hochrisikogebieten“ einzusetzen.

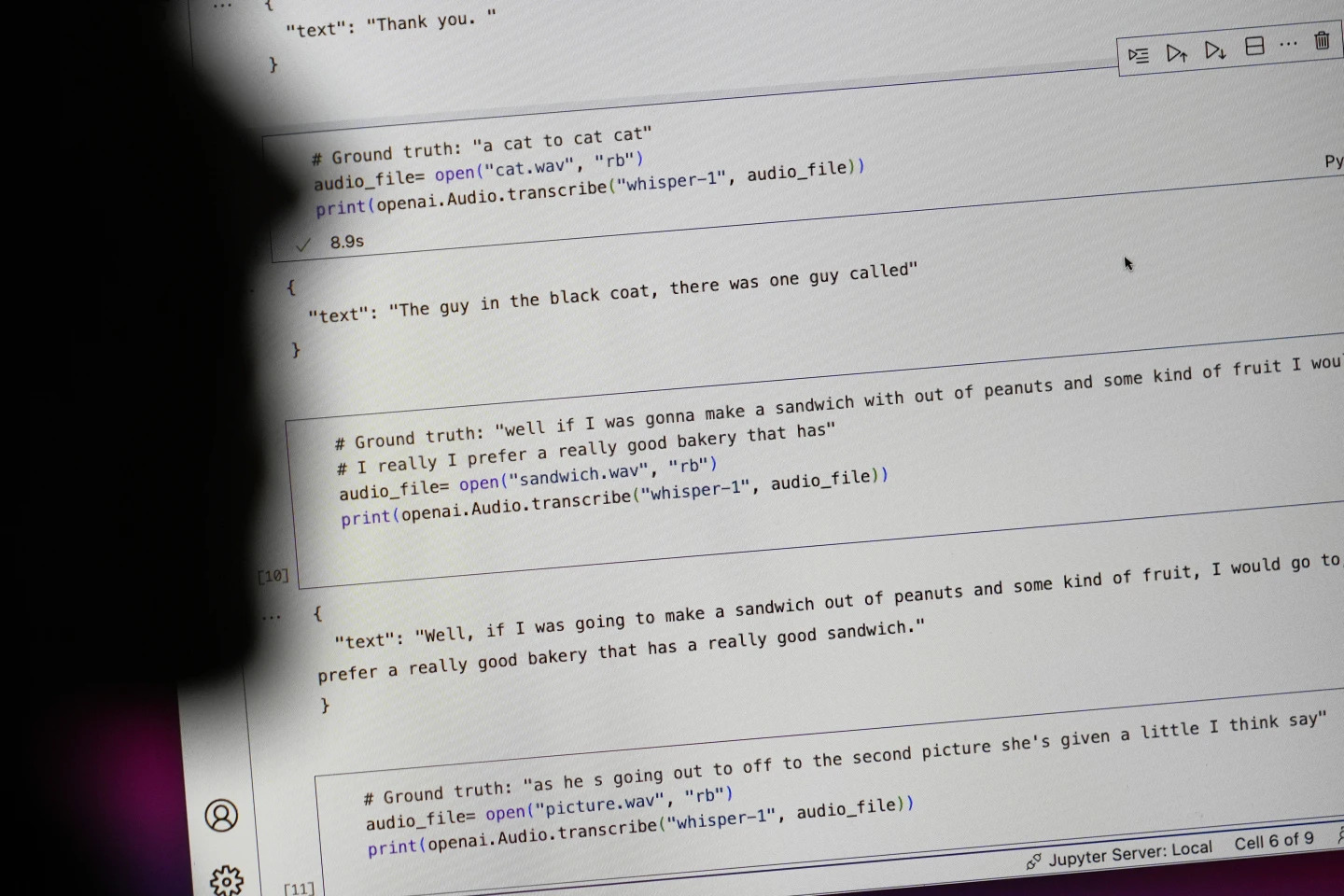

Sätze, die mit „#Ground truth“ beginnen, entsprechen dem, was tatsächlich gesagt wurde, Sätze, die mit „#text“ beginnen, entsprechen dem, was Whisper transkribiert hat. Foto: AP

Forscher und Ingenieure berichten, dass Whisper während der Nutzung häufig Halluzinationen hervorruft. Ein Forscher der University of Michigan gab beispielsweise an, bei acht von zehn untersuchten Aufnahmen Halluzinationen festgestellt zu haben.

Ein früherer Ingenieur für maschinelles Lernen fand in etwa der Hälfte der über 100 Stunden Whisper-Transkripte, die er analysierte, Manipulationen. Ein dritter Entwickler sagte, er habe in fast jedem der 26.000 mit Whisper erstellten Transkripte Halluzinationen gefunden.

Die Illusion bleibt selbst bei kurzen, gut aufgenommenen Audiobeispielen bestehen. Eine aktuelle Studie von Informatikern fand 187 Verzerrungen in mehr als 13.000 untersuchten klaren Audioclips.

Dieser Trend würde zu Zehntausenden von Fehlern bei Millionen von Aufzeichnungen führen, sagten die Forscher.

Solche Fehler können „wirklich ernste Konsequenzen“ haben, insbesondere in einem Krankenhausumfeld, sagte Alondra Nelson, Professorin an der School of Social Sciences des Institute for Advanced Study.

„Niemand möchte eine Fehldiagnose erhalten. Es muss eine höhere Hürde geben“, sagte Nelson.

Die Professorinnen Allison Koenecke von der Cornell University und Mona Sloane von der University of Virginia untersuchten Tausende von kurzen Textauszügen aus TalkBank, einem Forschungsarchiv der Carnegie Mellon University. Sie kamen zu dem Schluss, dass fast 40 Prozent der Halluzinationen schädlich oder verstörend waren, weil der Sprecher missverstanden oder falsch dargestellt werden konnte.

Ein Sprecher beschrieb in einer Aufnahme „zwei andere Mädchen und eine Frau“, aber Whisper erfand zusätzliche rassistische Kommentare und fügte hinzu: „zwei andere Mädchen und eine Frau, ähm, die schwarz war.“

In einer anderen Abschrift erfand Whisper ein nicht existierendes Medikament namens „Antibiotika mit erhöhter Aktivität“.

Während die meisten Entwickler einräumen, dass Transkriptionstools Rechtschreibfehler oder andere Fehler enthalten können, sagen Ingenieure und Forscher, dass sie noch nie ein KI-gestütztes Transkriptionstool gesehen haben, das so halluzinogen ist wie Whisper.

Das Tool ist in mehrere Versionen des OpenAI-Flaggschiff-Chatbots ChatGPT integriert und ist ein integrierter Dienst in der Cloud-Computing-Plattform von Oracle und Microsoft, der Tausenden von Unternehmen weltweit zur Verfügung steht. Es wird auch zum Transkribieren und Übersetzen von Text in viele Sprachen verwendet.

Ngoc Anh (laut AP)

[Anzeige_2]

Quelle: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Foto] Einzigartiges Phu Gia-Pferdehut-Webhandwerk](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760084018320_ndo_br_01-jpg.webp)

![[Foto] Ho-Chi-Minh-Stadt erstrahlt am Vorabend des 1. Parteitags (2025–2030) in Fahnen und Blumen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760102923219_ndo_br_thiet-ke-chua-co-ten-43-png.webp)

![[Foto] Eröffnung des Weltkulturfestivals in Hanoi](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760113426728_ndo_br_lehoi-khaimac-jpg.webp)

Kommentar (0)