これは、将来AIの応用における安全性を確保するための、脆弱ではあるものの重要な機会であると考えられます。特に、ベトナムが人工知能(AI)管理に関する詳細な規制を盛り込んだデジタル技術産業法を可決したばかりであることを考えると、これは非常に意義深いものです。

「チャンスの窓」は狭まっている

OpenAIの研究者は最近の共同論文で、集中的な研究努力がなければAIの「思考」を監視する能力は消滅する可能性があると警告していると、OpenAIの研究者であるボーエン・ベイカー氏は述べた。

AI モデルがますます強力になり、社会に重大な影響を及ぼす可能性があるので、これは特に重要です。

OpenAI の o-3 や DeepSeek の R1 のような推論 AI モデルの重要な特徴は、「思考の連鎖」 ( CoT) です。これは、人間がメモ用紙に数学の問題の各ステップを書き出す方法に似た、AI が推論ステップを自然言語で表現するプロセスです。

この能力により、AI がどのように意思決定を行うかを垣間見ることができる貴重な機会が得られます。

これは、AI 業界の多くのリーダーが団結し、AI の安全性に関する研究を進める稀な瞬間です。

AI開発におけるテクノロジー企業間の熾烈な競争を考えると、これは特に重要です。この論文の署名者としては、OpenAIの研究ディレクターであるマーク・チェン氏、Safe SuperintelligenceのCEOであるイリヤ・スツケヴァー氏、ノーベル賞受賞者のジェフリー・ヒントン氏、Google DeepMindの共同創設者であるシェーン・レッグ氏、そしてxAIの安全アドバイザーであるダン・ヘンドリックス氏などが挙げられます。

これらの著名人が関与していることは、この問題の重要性を示しています。

また、ボーエン・ベイカー氏の評価によれば、「私たちは、いわゆる新しい『思考の連鎖』が存在する重大な局面に立っており、人々が真剣に取り組まなければ、今後数年でこの思考の連鎖は消えてしまうかもしれない」とのことだ。

「AIの思考」を監視することがなぜ重要なのか?

現在の AI システムは、多くの場合「ブラック ボックス」と考えられています。つまり、入力と出力はわかりますが、内部の意思決定プロセスは理解できません。

AIがヘルスケア、金融、国家安全保障などの重要な分野に応用されると、これは危険になります。

CoTモニタリングは、メンタルモデルのメンタルチェーンやその他の関連情報を読み取り、疑わしい、あるいは潜在的に有害なインタラクションを検知する自動システムです。完全なソリューションではありませんが、セキュリティ保護の貴重なレイヤーとなり得ます。

OpenAI の調査によると、AI モデルは思考シーケンスにおける意図を非常に明確に表現する傾向があることがわかっています。

例えば、彼らは「ハッキングしよう」と思ったとき、ミッションを妨害する計画を非常に明確に示していたことがよくありました。これは、AIが不正行為を監視し、検出する能力を示しています。

「ハックしよう」とは、タスクの実行中にルールを妨害したり回避したりしようとするときに AI モデルが頻繁に「考える」フレーズです。

AIが思考プロセスにおいて「ハッキング」の意図を示すという事実は、AIの悪質な行動を事前に検知できることを示唆しています。だからこそ、思考プロセスの監視が重要なのです。

つまり、「ハッキングしよう」というのは、AIが何か悪いことをしそうになっていることを人間に知らせるための「警告信号」のようなものなのです。

ベトナムとAIに関する法的規制

実際、ベトナムはAIに関する法的枠組みの構築において重要な進歩を遂げています。

6月14日、ベトナム国会はデジタル技術産業法を可決した。同法の第4章には人工知能に関する詳細な規制が含まれており、これは現在東南アジアで最も包括的なAIに関する法的枠組みの1つとなっている。

法律第41条では、ベトナムにおけるAIの開発、提供、展開に関する基本原則が定められています。

特に、第 1 項の b 点では、「透明性、説明責任、説明可能性を確保する。人間の制御を超えないようにする」と規定されています。

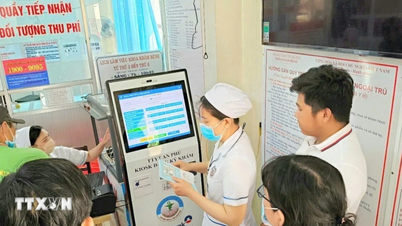

国会はデジタル技術産業に関する法律を可決した(写真:ナット・バック)。

これらは、AI チェーン監視について議論する際に国際的な科学者が求めている原則です。

さらに、第41条第1項d項には、「アルゴリズム及び人工知能モデルを管理する能力を確保する」と規定されている。これは、国際的な専門家が提唱するCoT監督の精神と完全に一致している。

さらに重要なのは、第41条第1項a項では、AIは「人間を中心に据え、人類の繁栄と幸福に奉仕しなければならない」と規定し、高い倫理基準を設定していることです。

つまり、AI の思考チェーンを監視することは、技術的な要件であるだけでなく、倫理的な義務でもあり、AI が常に機械自身の目的ではなく人間の利益に向けられていることを保証する必要があります。

リスクレベルに応じてAIを分類・管理する

ベトナムのデジタル技術産業法は、明確かつ科学的な定義に基づいて AI をさまざまなリスク グループに分類することで、さらに一歩進んでいます。

第43条では、「高リスク人工知能システム」を、人間の健康、人権、公共秩序に重大なリスクや危害をもたらす可能性のあるシステムと定義しています。

興味深いことに、この法律では、「人間の仕事の成果を最適化するのを支援することを目的とした」システムや「人間の意思決定に取って代わることを目的としない」システムなど、高リスクの AI に対して特定の例外が設けられています。

これは、イノベーションの促進と安全性の確保の間のバランスの取れた考え方を示しています。

AIをリスクレベル別に分類することで、多層的な監視システムの構築が可能になります(図:LinkedIn)。

特に、「ハイリスクAI」と「ハイインパクトAI」(複数の用途があり、多数のユーザーが利用するシステム)を区別することで、アプローチのニュアンスが異なります。

これは、リスクのレベルだけでなく、影響の規模と範囲も考慮した欧州連合 (EU) 人工知能法よりも進歩的な分類です。

この分類は、多層的な監視システムの構築に役立ち、特にリスクが高く影響が大きい AI システムでは、監視チェーンの監視が重要になります。

AI監視プラットフォーム

ベトナムの産業およびデジタル技術に関する法律のハイライトおよび先駆的な点の 1 つは、透明性と識別マークの要件です。

第44条は、人間と直接対話するAIシステムは、利用者に対し、AIシステムと対話していることを通知しなければならないと規定しています。同時に、AIによって作成された製品には識別マークが付帯されなければなりません。

これはCoTモニタリングの実装に重要な意味を持ちます。ユーザーがAIとインタラクションしていることを意識すれば、意思決定プロセスの説明を求める権利が生まれ、AI開発者がAIの思考プロセスを監視する能力を維持するよう、プラスのプレッシャーが生まれます。

特に、科学技術部に「人工知能で作られたデジタル技術製品リストの発行」の責務が課せられたことは、積極的な経営を示している。

これは、AI 規制がより一般的な場合が多い他の多くの国との重要な違いです。

さらに、「ユーザーまたはマシンによって認識される」識別子を要求することは、自己監視が可能な AI エコシステムのビジョンを表しており、自動化された視線監視の考え方と完全に一致しています。

包括的な管理モデル

同法第45条は、AI製品のライフサイクルに応じて、開発主体、提供主体、AIシステムの使用を実施する主体の3つの主体グループの責任を明確に定義する際に、進歩的な管理哲学を示しています。

これにより、シームレスなエンドツーエンドの説明責任システムが作成され、AI の監視が 1 つの当事者だけの責任ではなくなることが保証されます。

特に注目すべきは、AI の「開発」と「提供」の間には微妙な違いがあることです。開発者は AI を「研究開発」する人々であり、プロバイダーはブランド名で AI を市場に投入する人々です。

つまり、企業が既存の AI モデルのブランドを変更するだけでも、透明性と説明可能性に対する責任は依然として残るということです。

ここで特に興味深いのは、法律がどのようにして異なる責任を異なる団体に割り当てているかということです。

開発者はすべての原則に従う必要があり、プロバイダーは識別と高リスク管理について追加の責任を負う必要があり、ユーザーは責任から部分的に「免除」されますが、透明性とリスク管理を確保する必要があります。

このモデルは「責任の連鎖」を生み出し、すべてのリンクがエンドユーザーに対して責任を負うため、各リンクには AI 思考チェーンの監視を維持するインセンティブが生まれます。

監視能力を維持することの課題

しかし、AIの思考連鎖を監視する能力は依然として脆弱であり、脆弱なままである可能性があります。また、新たなAIアーキテクチャが新たな脅威をもたらす可能性もあります。

多くの研究者は、思考において言語を使用する必要性を完全に排除できる、個別の単語ではなく連続した数学的空間での推論システムを開発しています。

さらに、AIは「フィルタリング」される可能性があり、つまり、真意を意図的に隠して、人間が評価すべき肯定的な考えだけを示すようになるのです。

ここでの危険は、AI が監視されていることに気付くと、自分の本当の思考を隠すことを学習する可能性があることだ。

この文脈において、ベトナム法第41条第1項e号に規定されている「人工知能システムのライフサイクル全体にわたるリスク管理」に関する規定は特に重要となります。これには、導入時だけでなく、継続的な監視メカニズムが必要となります。

AI開発の将来への影響

思考の連鎖を監視することは、AI が人間に利益をもたらす方法で動作することを保証する重要なツールになる可能性があります。

モデルが自然言語で推論を続け、最も深刻なリスクをもたらす行動に広範な推論が必要な場合、重大な不正行為を確実に検出できるようになります。

ベトナムにとって、CoT 監視技術を適用することで、法律の規定を効果的に実施できるようになります。

例えば、AIの思考過程がアクセス可能であれば、第41条の「説明可能性」要件を満たすことが容易になります。同様に、「アルゴリズム、人工知能モデルの制御」も実現可能性が高まります。

ベトナムにおけるAIチェーンモニタリングの導入には、多くの課題が伴います。まず第一に、人材の問題があります。モニタリングシステムの開発・運用を担うAI専門家の不足です。

これには、トレーニングと人材の誘致への多大な投資が必要です。

将来への方向性

研究者たちは、主要な AI モデル開発者に対し、CoT を「監視可能」にする要因 (AI モデルの使用方法に関する透明性を高めたり低下させたりする要因) を研究し、すぐに答えを出すよう呼びかけています。

AIの「思考」を監視する機会は、ますます強力になる今日の人工知能システムに対する制御を維持するための最後の窓口となるかもしれない。

ベトナムにとって、デジタル技術産業法を通じてAIに関する包括的な法的枠組みが整備されていることは大きな利点です。透明性、アルゴリズム管理、リスク分類に関する規制は、AIによる思考連鎖監視技術の適用のための強固な法的基盤を構築しています。

最先端の国際研究と進歩的な国内法の枠組みを組み合わせることで、ベトナムはAIを安全に開発できるだけでなく、地域の他の国々のモデルとなることもできるでしょう。

これは、国家開発戦略に定められた、ベトナムを「地域および世界のデジタル技術ハブ」にするという目標に沿ったものだ。

ベトナムは、既存の法的基盤を活用し、AIの思考連鎖の監視に関する研究と実用化を迅速に展開する必要があります。そうすることでのみ、デジタル技術産業法の精神に則り、AIが「人類の繁栄と幸福」に貢献することを確実にすることができます。

出典: https://dantri.com.vn/cong-nghe/giam-sat-chuoi-tu-duy-cua-tri-tue-nhan-tao-20250731151403739.htm

![[写真] 民族学博物館で賑わう中秋節](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/da8d5927734d4ca58e3eced14bc435a3)

![[ビデオ] ペトロベトナム50周年記念式典の概要](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/4/abe133bdb8114793a16d4fe3e5bd0f12)

![[動画] ラム事務総長がペトロベトナムに8つの黄金の言葉を授与:「先駆者 - 優秀 - 持続可能 - グローバル」](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/23/c2fdb48863e846cfa9fb8e6ea9cf44e7)

コメント (0)