Artificial Intelligence (AI) គឺជាប្រធានបទនៃការពិភាក្សាដ៏ធំបំផុតនៅក្នុងឧស្សាហកម្មបច្ចេកវិទ្យាចាប់តាំងពី OpenAI បានប្រកាស ChatGPT ក្នុងខែវិច្ឆិកា ឆ្នាំ 2022។ ភ្លាមៗបន្ទាប់ពីនោះ ក្រុមហ៊ុនដូចជា Google, Meta, Microsoft... ក៏បានវិនិយោគយ៉ាងច្រើននៅក្នុងកិច្ចខិតខំប្រឹងប្រែង AI ផ្ទាល់ខ្លួនរបស់ពួកគេ។

Big Tech មិនខ្មាស់អៀនចំពោះមហិច្ឆតា AI របស់ខ្លួនទេ ប៉ុន្តែថ្មីៗនេះ វាបានកំពុងដោះស្រាយយ៉ាងស្ងៀមស្ងាត់នូវហានិភ័យដែលបច្ចេកវិទ្យាបង្កឡើងចំពោះអាជីវកម្មរបស់ខ្លួន។ នៅក្នុងរបាយការណ៍ប្រចាំឆ្នាំ 2023 របស់ខ្លួន Alphabet ដែលជាក្រុមហ៊ុនមេរបស់ Google បាននិយាយថា ផលិតផល និងសេវាកម្ម AI បង្កបញ្ហាប្រកបដោយក្រមសីលធម៌ បច្ចេកវិទ្យា ច្បាប់ និយតកម្ម និងបញ្ហាប្រឈមផ្សេងទៀតដែលអាចជះឥទ្ធិពលអវិជ្ជមានដល់ម៉ាកយីហោ និងតម្រូវការរបស់វា។

យោងតាម Bloomberg, Meta, Microsoft និង Oracle ក៏បានលើកឡើងពីការព្រួយបារម្ភអំពី AI នៅក្នុងឯកសាររបស់ពួកគេជាមួយគណៈកម្មការមូលបត្រអាមេរិក (SEC) ដែលជារឿយៗស្ថិតនៅក្រោមផ្នែក "កត្តាហានិភ័យ" ។ ជាឧទាហរណ៍ ក្រុមហ៊ុន Microsoft បាននិយាយថា លក្ខណៈពិសេស AI ទូទៅអាចងាយរងគ្រោះទៅនឹងការគំរាមកំហែងផ្នែកសុវត្ថិភាពដែលមិនបានមើលឃើញទុកជាមុន។

នៅក្នុងរបាយការណ៍ប្រចាំឆ្នាំ 2023 របស់ Meta ក្រុមហ៊ុនមេរបស់ Facebook បានសង្កត់ធ្ងន់ថា "មានហានិភ័យសំខាន់ៗដែលទាក់ទងនឹងការអភិវឌ្ឍន៍ និងការដាក់ឱ្យប្រើប្រាស់ AI" ហើយថា "មិនអាចមានការធានាថាការប្រើប្រាស់ AI នឹងធ្វើឱ្យសេវាកម្ម ផលិតផល ឬប្រតិបត្តិការអាជីវកម្មកាន់តែប្រសើរឡើងនោះទេ។" មេតាបានចុះបញ្ជីសេណារីយ៉ូ AI ដែលអាចបង្កគ្រោះថ្នាក់ដល់អ្នកប្រើប្រាស់ និងបង្ហាញពួកគេទៅនឹងវិវាទ ដូចជាព័ត៌មានមិនពិត (ដូចជានៅក្នុងការបោះឆ្នោត) ខ្លឹមសារដែលបង្កគ្រោះថ្នាក់ ការរំលោភបំពានកម្មសិទ្ធិបញ្ញា និងឯកជនភាពទិន្នន័យ។

ទន្ទឹមនឹងនេះ សាធារណជនក៏បានសម្តែងការព្រួយបារម្ភអំពី AI ដែលធ្វើឱ្យការងារមួយចំនួនលែងប្រើ ឬបាត់ ឬគំរូភាសាធំៗដែលត្រូវបានបណ្តុះបណ្តាលលើទិន្នន័យផ្ទាល់ខ្លួនដែលផ្សព្វផ្សាយព័ត៌មានមិនពិត។

នៅថ្ងៃទី 4 ខែមិថុនា ក្រុមអតីតនិយោជិត OpenAI មួយក្រុមបានផ្ញើ "លិខិតចេតនា" សុំឱ្យក្រុមហ៊ុនបច្ចេកវិទ្យាធ្វើបន្ថែមទៀតដើម្បីកាត់បន្ថយហានិភ័យនៃ AI ។ ពួកគេមានការព្រួយបារម្ភថា AI បង្កើនវិសមភាព ឧបាយកល ព័ត៌មានមិនពិត និងប្រព័ន្ធ AI ស្វ័យប្រវត្តិដែលមិនអាចគ្រប់គ្រងបានគំរាមកំហែងដល់ការរស់រានមានជីវិតរបស់មនុស្សជាតិ។

ប្រភព

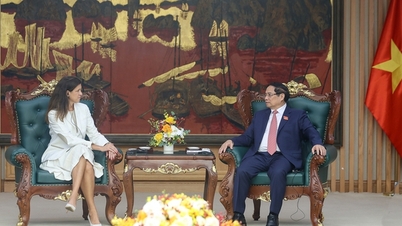

![[រូបថត] អគ្គលេខាបក្ស To Lam ទទួលជួបឯកអគ្គរដ្ឋទូតអាមេរិកប្រចាំនៅវៀតណាម Marc Knapper](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/29/c8fd0761aa184da7814aee57d87c49b3)

![[រូបថត] មហាសន្និបាតលើកទី ១ របស់គណៈកម្មាធិការបក្សខេត្ត Phu Tho អាណត្តិ ២០២៥-២០៣០](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/30/1507da06216649bba8a1ce6251816820)

![[រូបថត] ការបើកមហាសន្និបាតបក្សយោធាលើកទី ១២ សម្រាប់អាណត្តិ ២០២៥-២០៣០](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/30/2cd383b3130d41a1a4b5ace0d5eb989d)

![[រូបថត] អគ្គលេខាធិកា To Lam លេខាគណៈកម្មាធិការយោធាមជ្ឈិមចូលរួមមហាសន្និបាតបក្សលើកទី ១២ នៃកងទ័ព](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/30/9b63aaa37ddb472ead84e3870a8ae825)

![[រូបថត] អគ្គលេខាធិកា To Lam ចូលរួមក្នុងពិធីអបអរសាទរខួបលើកទី 80 នៃវិស័យប្រៃសណីយ៍ និងទូរគមនាគមន៍ និងខួបលើកទី 66 នៃវិស័យវិទ្យាសាស្ត្រ និងបច្ចេកវិទ្យា។](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/29/8e86b39b8fe44121a2b14a031f4cef46)

Kommentar (0)