(CLO) OpenAI의 음성-텍스트 변환 도구인 Whisper는 "인간 수준에 가까운 견고성과 정확성"을 자랑하지만, 하나의 큰 단점이 있습니다. 텍스트 조각이나 심지어 전체 문장을 조작할 가능성이 있다는 것입니다!

전문가들은 업계에서 환각적이라고 알려진 일부 텍스트에는 인종적 논평, 폭력, 심지어 상상의 의료 치료법이 포함될 수 있다고 말합니다.

전문가들은 Whisper가 전 세계 여러 산업에서 인터뷰를 번역하고 필사하고, 텍스트를 생성하고 영상에 자막을 넣는 데 사용되기 때문에 이러한 조작이 심각하다고 말합니다.

더욱 우려스러운 점은 OpenAI가 "고위험 지역"에서는 이 도구를 사용해서는 안 된다고 경고했음에도 불구하고, 의료 센터에서는 환자와 의사의 상담을 기록하기 위해 Whisper 기반 도구를 사용하고 있다는 것입니다.

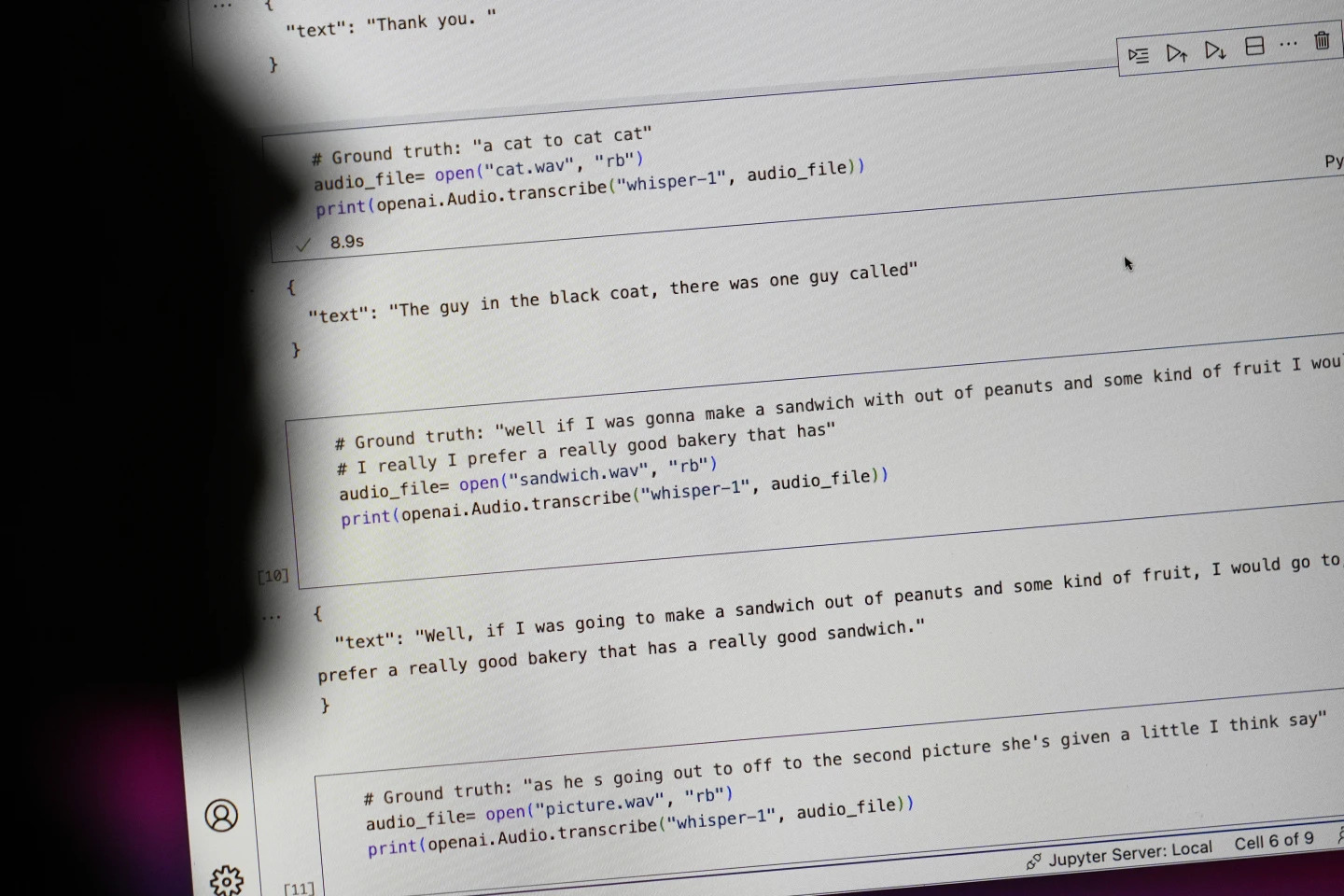

"#Ground truth"로 시작하는 문장은 실제로 말한 내용이고, "#text"로 시작하는 문장은 위스퍼가 필사한 내용입니다. 사진: AP

연구원들과 엔지니어들은 위스퍼가 사용 중 환각을 자주 유발한다고 말합니다. 예를 들어, 미시간 대학교의 한 연구원은 자신이 검토한 녹음 파일 10개 중 8개에서 환각을 발견했다고 말했습니다.

초기 머신러닝 엔지니어는 자신이 분석한 100시간 이상의 위스퍼 대화 내용 중 약 절반에서 조작을 발견했습니다. 세 번째 개발자는 위스퍼로 생성된 26,000개의 대화 내용 중 거의 모든 내용에서 환각을 발견했다고 말했습니다.

이러한 착시는 짧고 잘 녹음된 오디오 샘플에서도 지속됩니다. 컴퓨터 과학자 들의 최근 연구에 따르면, 13,000개 이상의 선명한 오디오 클립에서 187개의 왜곡이 발견되었습니다.

연구자들은 그러한 추세로 인해 수백만 건의 녹음에서 수만 건의 오류가 발생할 수 있다고 말했습니다.

고등연구소 사회과학대학의 알론드라 넬슨 교수는 이러한 실수는 특히 병원 환경에서 "정말 심각한 결과"를 초래할 수 있다고 말했습니다.

"아무도 오진을 받고 싶어 하지 않습니다. 더 높은 장벽이 필요합니다."라고 넬슨은 말했습니다.

코넬 대학교의 앨리슨 코네케 교수와 버지니아 대학교의 모나 슬론 교수는 카네기 멜론 대학교에 소장된 연구 자료실인 토크뱅크에서 발췌한 수천 개의 짧은 발췌문을 분석했습니다. 그 결과, 환각의 약 40%가 화자의 말이 오해받거나 왜곡될 수 있기 때문에 해롭거나 불쾌감을 주는 것으로 나타났습니다.

한 녹음에서 한 화자는 "다른 두 소녀와 한 여성"을 묘사했지만, 위스퍼는 추가적인 인종적 논평을 조작하여 "다른 두 소녀와 한 여성, 음, 흑인"을 추가했습니다.

또 다른 기록에 따르면, 위스퍼는 "활성이 증가된 항생제"라는 존재하지 않는 약을 발명했습니다.

대부분의 개발자는 필사 도구가 철자 오류나 기타 오류를 범할 수 있다는 것을 인정하지만, 엔지니어와 연구자들은 Whisper만큼 환각적인 AI 기반 필사 도구를 본 적이 없다고 말합니다.

이 도구는 OpenAI의 주력 챗봇인 ChatGPT의 여러 버전에 통합되어 있으며, Oracle과 Microsoft의 클라우드 컴퓨팅 플랫폼에 통합되어 전 세계 수천 개 기업에 서비스를 제공하고 있습니다. 또한 텍스트를 여러 언어로 필사하고 번역하는 데에도 사용됩니다.

응옥 안 (AP에 따르면)

[광고_2]

출처: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[사진] 하노이 세계문화축제 개막](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760113426728_ndo_br_lehoi-khaimac-jpg.webp)

![[사진] 2025~2030년 임기 제1차 당대회를 앞두고 호치민시는 국기와 꽃으로 화려하게 빛났다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760102923219_ndo_br_thiet-ke-chua-co-ten-43-png.webp)

![[Ảnh] Độc đáo nghề chằm nón ngựa Phú Gia](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/10/1760084018320_ndo_br_01-jpg.webp)

댓글 (0)