Nvidia war einst als Hersteller von Chips für Videospiele bekannt, hat seinen Schwerpunkt in den letzten Jahren jedoch auf den Rechenzentrumsmarkt verlagert.

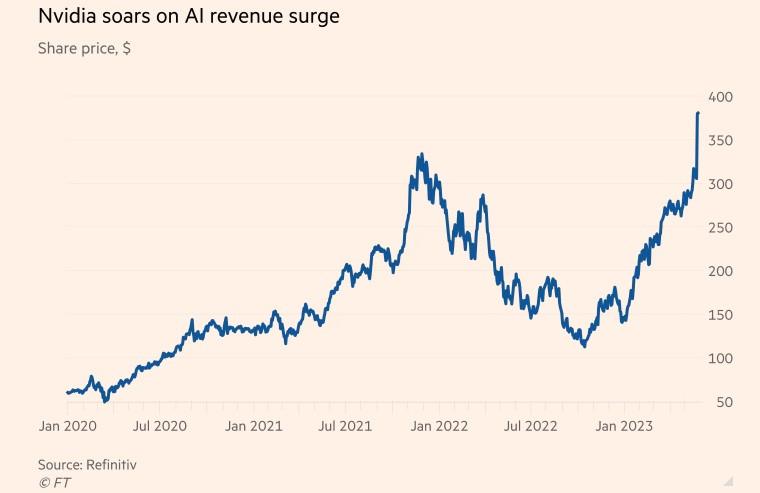

Der US-Chiphersteller florierte während der Pandemie, da die Nachfrage nach Gaming- und Cloud-Anwendungen stark anstieg und sich ein weltweiter Kryptowährungs-Mining-Wahn ausbreitete. Zum Ende des am 29. Januar endenden Geschäftsjahres machte das Geschäft mit Rechenzentrumschips mehr als 50 % des Umsatzes des Unternehmens aus.

Unterdessen hat der beliebte Chatbot ChatGPT die generative künstliche Intelligenz (KI) in diesem Jahr auf die nächste Stufe gehoben und nutzt riesige Mengen vorhandener Daten, um neue Inhalte zu Themen von Poesie bis Computerprogrammierung zu generieren.

Microsoft und Alphabet, zwei Technologiegiganten, die auch im KI-Bereich eine wichtige Rolle spielen, glauben, dass generative Technologie die Arbeitsweise der Menschen verändern kann. Beide haben einen Wettlauf um die Integration von KI in Suchmaschinen und Bürosoftware gestartet, mit dem Ziel, diese Branche zu dominieren.

Goldman Sachs schätzt, dass die US-Investitionen in KI bis 2030 fast 1 % der Wirtschaftsleistung des Landes betragen könnten.

Supercomputer, die zur Datenverarbeitung und generativen KI eingesetzt werden, basieren auf Grafikprozessoren (GPUs). GPUs sind für die spezifischen Berechnungen im KI-Computing konzipiert und deutlich effizienter als die zentralen Prozessoren anderer Chiphersteller wie Intel. ChatGPT von OpenAI wird beispielsweise von Tausenden von Nvidia-GPUs angetrieben.

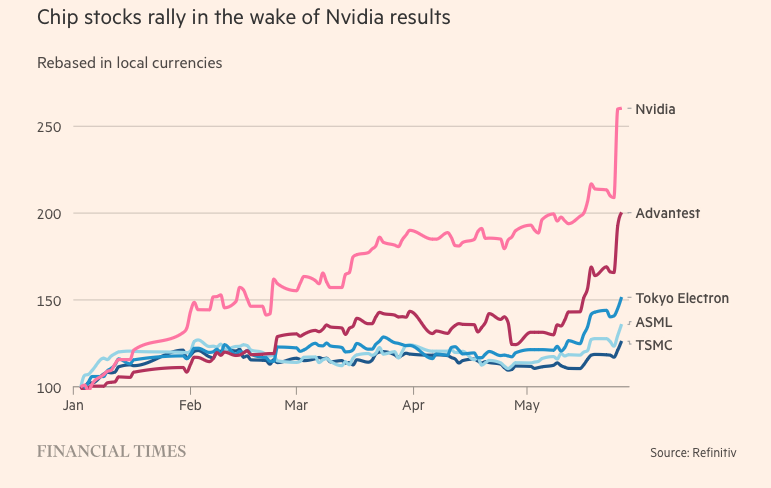

Mittlerweile hält Nvidia etwa 80 % des GPU-Marktanteils. Zu den Hauptkonkurrenten von Nvidia zählen Advanced Micro Devices und hauseigene KI-Chips von Technologieunternehmen wie Amazon, Google und Meta Platforms.

Das Geheimnis der Sublimation

Der Durchbruch des Unternehmens war der H100, ein Chip auf Basis von Nvidias neuer Architektur namens „Hopper“ – benannt nach der amerikanischen Programmierpionierin Grace Hopper. Die explosionsartige Verbreitung künstlicher Intelligenz hat den H100 zum heißesten Produkt im Silicon Valley gemacht.

Die in Rechenzentren verwendeten übergroßen Chips verfügen über 80 Milliarden Transistoren – fünfmal so viel Silizium wie die neuesten iPhones. Obwohl sie doppelt so viel kosten wie ihr Vorgänger, der A100 (erschienen 2020), bieten H100-Nutzer nach eigenen Angaben die dreifache Leistung.

Der H100 erfreut sich insbesondere bei „Big Tech“-Unternehmen wie Microsoft und Amazon großer Beliebtheit, die ganze Rechenzentren speziell für KI-Workloads aufbauen, sowie bei KI-Startups der neuen Generation wie OpenAI, Anthropic, Stability AI und Inflection AI, da er eine höhere Leistung verspricht, die Produkteinführungen beschleunigen oder die Schulungskosten im Laufe der Zeit senken kann.

„Dies ist eine der knappsten technischen Ressourcen, die es gibt“, sagte Brannin McBee, Chief Strategy Officer und Gründer von CoreWeave, einem KI-basierten Cloud-Startup, das Anfang des Jahres als eines der ersten Unternehmen H100-Lieferungen erhielt.

Andere Kunden haben nicht so viel Glück wie CoreWeave. Sie mussten bis zu sechs Monate auf Produkte warten, mit denen sie ihre riesigen Datensätze trainieren konnten. Viele KI-Startups befürchten, dass Nvidia die Marktnachfrage nicht decken kann.

Elon Musk bestellte außerdem Tausende von Nvidia-Chips für sein KI-Startup und sagte: „GPUs sind derzeit schwerer zu bekommen als Medikamente.“

„Die Computerkosten sind in die Höhe geschossen. Der Mindestbetrag, der für Serverhardware ausgegeben wird, die zum Aufbau kreativer KI verwendet wird, hat 250 Millionen Dollar erreicht“, teilte der Tesla-CEO mit.

Wenn der H100 aktuell ist, liegt Nvidias Durchbruch im Bereich der künstlichen Intelligenz zwei Jahrzehnte zurück und ist eher auf Software- als auf Hardware-Innovationen zurückzuführen. Im Jahr 2006 führte das Unternehmen die Cuda-Software ein, die GPUs nutzt, um Aufgaben zu beschleunigen, die über die Grafik hinausgehen.

„Nvidia hat die Zukunft vor allen anderen erkannt und sich auf programmierbare GPUs konzentriert. Sie haben die Chance erkannt, große Risiken eingegangen und ihre Konkurrenten konsequent überholt“, sagte Nathan Benaich, Partner bei Air Street Capital und Investor in KI-Startups .

(Laut Reuters, FT)

[Anzeige_2]

Quelle

Kommentar (0)