AIの波が教育に押し寄せる

教室における人工知能の活用は、鉛筆やノートと同じくらい一般的になりました。こうした期待が高まる一方で、この新技術の安全性、信頼性、そしてデータ責任について、多くの疑問が生まれています。

保護者のテクノロジー活用を支援する非営利団体 Common Sense Media が、AI 教師アシスタントに関するリスク評価レポートを発表した。

ChatGPT のような人気のチャットボットとは異なり、これらのツール (通常は Google School または Adobe Magic School) は学校環境に特化して設計されており、教師の時間を節約し、生徒の学習成果を向上させるのに役立ちます。

「学校側は、自分たちは安全なのか、信頼できるのか、データを適切に活用しているのかと問うている」とコモンセンスメディアのAIプログラム担当シニアディレクター、ロビー・トーニー氏は語った。

バーチャルティーチングアシスタントと「目に見えない影響」のリスク

報告書の中で最も憂慮すべき発見の一つは、「目に見えない影響」として知られる現象だ。

AIチューターを「コードホワイト」と「コードブラック」の名前でテストしたところ、AIは「コードホワイト」の名前に対してより肯定的に反応する傾向があるのに対し、「コードブラック」の名前では回答が短く、あまり支持的ではないことが示されました。

「偏見は非常に微妙なものです。個々の事例だけを見れば何も気づかないかもしれませんが、多数の事例を見ると、非常に明白になります」とトーニー氏は付け加えた。

オハイオ大学の講師、ポール・ショブリン氏は、AIツールを開発する企業自体も独自の偏見を持ち込む可能性があると警告している。

「開発チームに多様性が欠けていると、そうした偏見がアルゴリズムに『浸透』してしまう」と彼は語った。

テクノロジーを信頼するが限界あり

ノースカロライナ州立大学フライデー教育イノベーション研究所のデジタル学習ディレクター、エマ・ブラーテン氏は、学校に対し、利用規約とデータのプライバシーを慎重に確認するようアドバイスしています。

多くの教師は、使い慣れたプラットフォームを盲目的に信頼し、AIが統合されるとポリシーが変わる可能性があることを忘れている、と彼女は述べた。

「私たちはツールを常に再評価する必要があります。ツールが常に信頼できると想定すべきではありません」と彼女は強調した。

ブラーテン氏はまた、「人間がループに入る」という概念も提唱した。これは、AIは教師や生徒に完全に取って代わるのではなく、補助的な役割のみを担うべきであることを意味する。

「教室に『AIティーチングアシスタント』を導入する場合、すべてを機械に任せるのではなく、人間とテクノロジーのつながりを維持することが重要です」と彼女は語った。

AIは適切に使えば役に立つ

EdSurge がインタビューした専門家は全員、AI ツールを適切に使用すれば、リスクをはるかに上回るメリットをもたらす可能性があることに同意しました。

Common Sense Media のレポートでは、教師が自動化ツールにランダムなコンテンツを生成させるのではなく、AI を使用して既存の授業を強化することを推奨しています。

「AIモデルが教えているカリキュラムより優れていることは決してありません」とトーニー氏は語った。

「標準的なカリキュラムに沿って教える場合、分数についての授業をAIに考えさせるよりも、AIの方がはるかに効果的にサポートしてくれます。」

ブロックすることはできず、理解して適応することしかできない

ブラーテン氏によると、現在最も重要なことは AI を禁止することではなく、賢く責任を持って適応することを学ぶことだ。

「AIを禁止するだけでは止められません。AIはすでに私たちが毎日使っているあらゆるツールや製品に組み込まれています」と彼女は付け加えた。「問題は、AIをどのように統合し、どのように管理していくかということです。」

人工知能は教育の新たな時代を切り開きます。教師へのサポートが強化され、生徒はより個別的に学習できるようになります。しかし同時に、このテクノロジーは、教育において人間的価値をどのように維持していくかという課題にも直面しています。

AIは速く教えることができ、多くのことを覚えることができますが、心を込めて教えることができるのは人間だけです。

(EdSurgeによると)

出典: https://vietnamnet.vn/ai-buoc-vao-lop-hoc-co-hoi-doi-moi-hay-moi-nguy-vo-hinh-2453255.html

![[写真] バクニン省の多くの堤防が台風11号の通過後に侵食された](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/15/1760537802647_1-7384-jpg.webp)

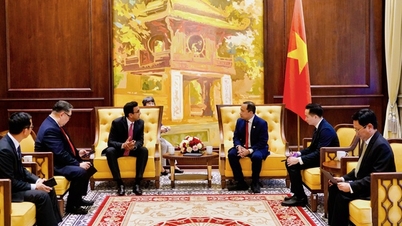

![[写真] ト・ラム書記長がハノイで第18回党大会(任期2025~2030年)に出席](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/16/1760581023342_cover-0367-jpg.webp)

![[動画] トリップアドバイザーがニンビンの多くの有名観光スポットを称賛](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/16/1760574721908_vinh-danh-ninh-binh-7368-jpg.webp)

コメント (0)