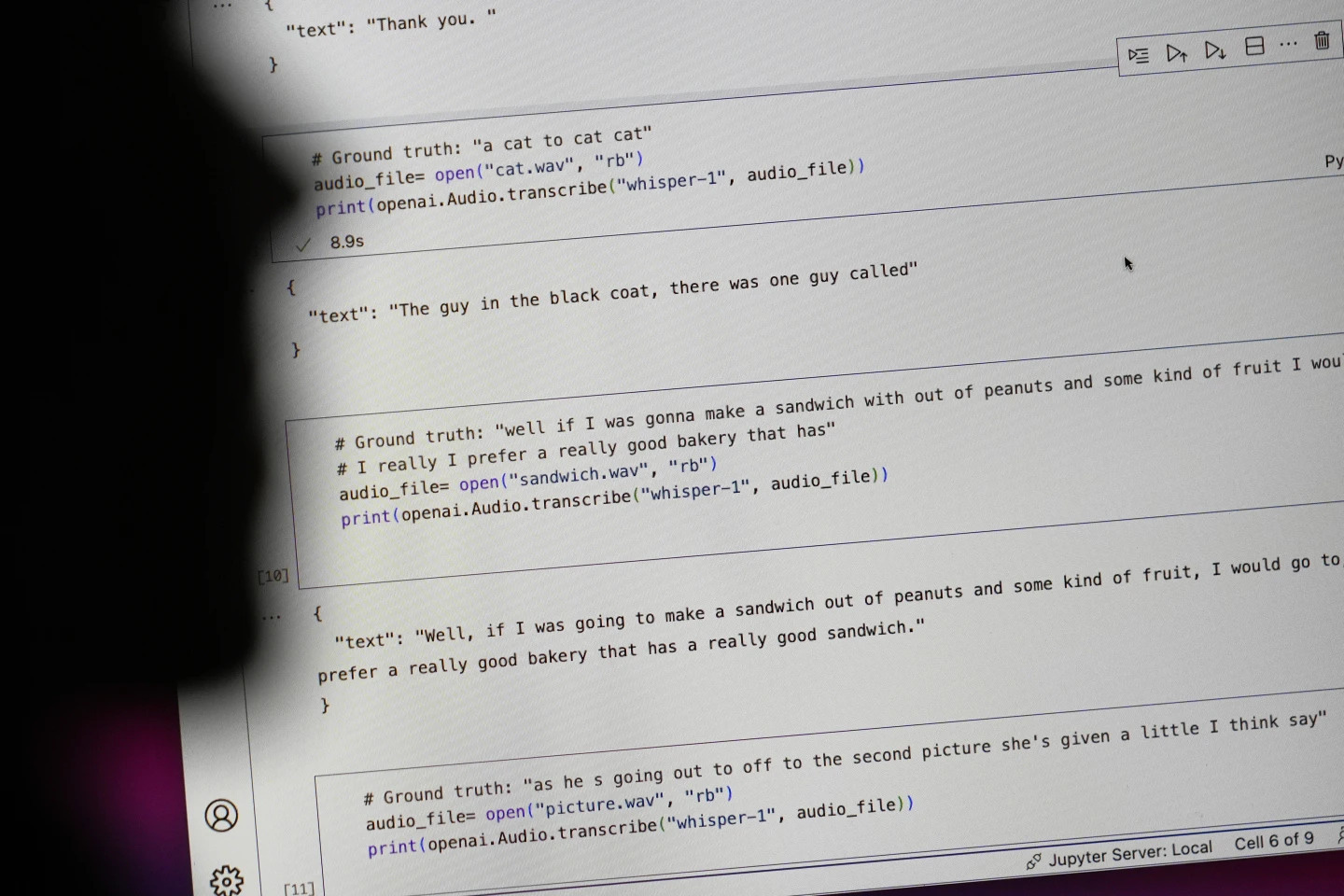

기술 대기업 OpenAI는 자사의 음성-텍스트 변환 도구인 위스퍼(Whisper)를 '인간과 같은 정확성과 견고성'을 갖춘 AI라고 홍보했습니다. 하지만 위스퍼에는 큰 단점이 하나 있었습니다. 완전히 허위인 텍스트와 문장을 생성했다는 것입니다.

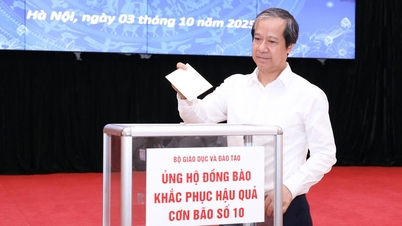

AI가 생성한 텍스트 중 일부(환각이라고 함)에는 인종적 언급, 폭력적인 언어, 심지어 상상의 의료 치료까지 포함될 수 있습니다. 사진: AP

AP에 따르면, 전문가들은 AI가 생성한 텍스트 중 일부는 소위 "환각적"이라고 불리는데, 여기에는 인종적 언급, 폭력적인 언어, 심지어 상상의 의료 치료법까지 포함된다고 말합니다.

AI가 생성한 텍스트의 높은 "환상" 비율

전문가들은 Whisper가 전 세계 여러 산업에서 인터뷰 번역 및 필사, 인기 있는 소비자 기술에 대한 텍스트 생성, 비디오 자막 생성 등에 널리 사용되고 있기 때문에 특히 우려하고 있습니다.

더욱 우려스러운 점은 많은 의료 센터에서 의사와 환자 간의 상담을 전송하기 위해 Whisper를 사용하고 있다는 점인데, OpenAI는 이 도구를 "고위험" 지역에서 사용해서는 안 된다고 경고했습니다.

문제의 전체 규모를 파악하기는 어렵지만, 연구자와 엔지니어들은 업무 과정에서 위스퍼 "환각"을 정기적으로 접한다고 말합니다.

미시간 대학교의 한 연구원은 자신이 검토한 오디오 녹취록 10개 중 8개에서 "환각"을 발견했다고 밝혔습니다. 한 컴퓨터 엔지니어는 자신이 분석한 100시간 이상의 오디오 녹취록 중 약 절반에서 "환각"을 발견했습니다. 또 다른 개발자는 위스퍼를 사용하여 만든 2만 6천 개의 녹음 파일 거의 전부에서 "환각"을 발견했다고 말했습니다.

짧고 명확하게 녹음된 오디오 샘플에서도 이 문제는 여전히 존재합니다. 컴퓨터 과학자 들의 최근 연구에 따르면, 13,000개 이상의 명확한 오디오 클립을 조사한 결과 187개의 "착시 현상"이 발견되었습니다. 연구진은 이러한 경향으로 인해 수백만 개의 녹음 파일에서 수만 개의 잘못된 필사가 발생할 수 있다고 밝혔습니다.

작년까지 바이든 행정부에서 백악관 과학기술국장을 지낸 알론드라 넬슨에 따르면, 이러한 오류는 특히 병원 환경에서 "매우 심각한 결과"를 초래할 수 있습니다.

"아무도 오진을 원하지 않습니다." 현재 뉴저지주 프린스턴 고등연구소 교수인 넬슨은 말했다. "더 높은 기준이 필요합니다."

위스퍼는 청각 장애인과 난청인을 위한 자막 제작에도 사용되는데, 이들은 특히 오역의 위험이 높습니다. 청각 장애인이자 갈로뎃 대학교 기술 접근성 프로그램 책임자인 크리스티안 보글러는 청각 장애인과 난청인이 "다른 모든 텍스트에 숨겨진" 조작된 문구를 식별할 방법이 없기 때문이라고 말합니다.

OpenAI는 문제를 해결하기 위해 요청되었습니다.

이러한 "환각"이 만연함에 따라 전문가, 옹호자, 그리고 전 OpenAI 직원들은 연방 정부에 AI 규제를 검토할 것을 촉구했습니다. OpenAI는 최소한 이러한 결함을 해결해야 합니다.

샌프란시스코의 연구 엔지니어인 윌리엄 샌더스는 "회사가 이 문제를 우선순위에 두려고 한다면 이 문제는 해결될 수 있다"고 말했다. 그는 회사의 방향에 대한 우려로 2월에 OpenAI를 떠났다.

"만약 공개해서 사람들이 그 기능에 너무 자신감을 갖고 다른 시스템에도 통합한다면 문제가 될 겁니다." OpenAI 대변인은 회사가 "환상"을 완화할 방법을 끊임없이 연구하고 있으며 연구자들의 연구 결과에 감사하고 있다고 말하며, OpenAI는 피드백을 모델 업데이트에 반영한다고 덧붙였습니다.

대부분의 개발자는 텍스트 음성 변환 도구가 오타나 다른 실수를 할 수 있다고 생각하지만, 엔지니어와 연구자들은 Whisper만큼 "환각"을 일으키는 AI 기반 텍스트 음성 변환 도구를 본 적이 없다고 말합니다.

2024년 노벨 물리학상: AI의 기반을 마련한 사람들

2024년 노벨 물리학상: AI의 기반을 마련한 사람들[광고_2]

출처: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[사진] 빈민초등학교 학생들이 보름달 축제를 즐기며 어린 시절의 기쁨을 만끽하고 있다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[사진] 팜 민 찐 총리, 10호 태풍 피해 극복 위한 회의 주재](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

댓글 (0)