DeepSeek의 연구원들은 V3.2-exp라는 새로운 실험 모델을 발표했습니다. 이 모델은 장기 컨텍스트 작업에 사용될 때 추론 비용을 크게 줄이도록 설계되었습니다.

DeepSeek은 Hugging Face에 게시물을 올려 해당 모델을 발표했으며, GitHub에도 관련 학술 논문을 게시했습니다.

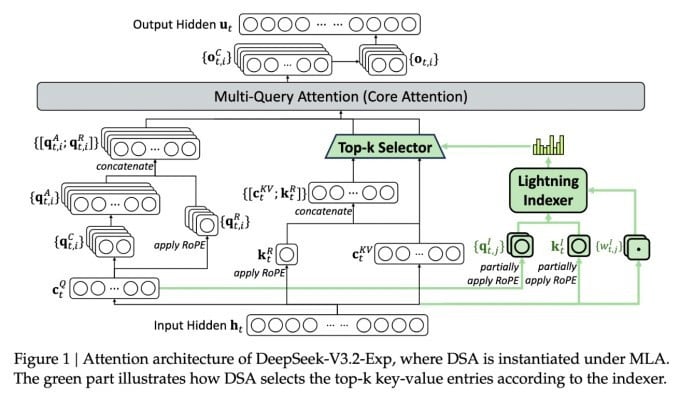

이 복잡한 새 모델의 가장 중요한 기능은 DeepSeek Sparse Attention입니다. 기본적으로 이 시스템은 "라이트닝 인덱서"라는 모듈을 사용하여 컨텍스트 창에서 특정 발췌문의 우선순위를 지정합니다.

DeepSeek에서 비용 효율적인 추론 모델을 발표했습니다.

"세분화된 토큰 선택 시스템"이라는 별도의 시스템이 해당 스니펫에서 특정 토큰을 선택하여 모듈의 제한된 어텐션 윈도우에 로드합니다. 이 두 가지 시스템을 결합하면, 희소 어텐션 모델이 비교적 적은 서버 부하로 긴 컨텍스트 조각에 대해 작동할 수 있습니다.

긴 컨텍스트 작업의 경우, 이 시스템의 이점은 상당합니다. DeepSeek의 예비 테스트 결과, 긴 컨텍스트 시나리오에서 간단한 추론 함수(API) 호출 비용을 최대 절반까지 줄일 수 있는 것으로 나타났습니다.

더욱 견고한 평가를 구축하기 위해서는 추가적인 테스트가 필요하지만, 해당 모델이 Hugging Face에서 공개되어 무료로 제공되므로, 제3자 테스트를 통해 논문의 주장을 평가하는 데 오랜 시간이 걸리지 않을 것으로 예상됩니다.

많은 에너지를 소모하는 다른 AI 챗봇 모델과 달리, DeepSeek은 훈련부터 운영까지 비용을 절감하는 방향으로 나아갑니다.

DeepSeek의 새로운 모델은 추론 비용 문제를 해결하기 위한 최근의 일련의 획기적인 성과 중 하나입니다. 추론 비용이란 기본적으로 사전 훈련된 AI 모델을 실행하는 데 드는 서버 비용으로, 모델을 훈련하는 데 드는 비용과는 반대 개념입니다.

DeepSeek의 경우, 연구원들은 기본 변압기 아키텍처를 더 효율적으로 만들 수 있는 방법을 찾고 있었고, 상당한 개선이 필요하다는 것을 발견했습니다.

중국에 본사를 둔 DeepSeek은 AI 열풍에서 특이한 존재입니다. 특히 AI 연구를 미국과 중국의 경쟁으로 보는 사람들에게는 더욱 그렇습니다. DeepSeek은 올해 초 미국 경쟁사보다 훨씬 저렴한 비용으로 강화 학습을 기반으로 학습한 R1 모델을 선보이며 큰 주목을 받았습니다.

그러나 이 모델은 일부 사람들이 예상했던 대로 AI 훈련 분야의 본격적인 혁명을 일으키지 못했고, 이 회사는 그 후 몇 달 동안 서서히 주목에서 물러났습니다.

새로운 "희소 주의" 접근 방식은 R1만큼 큰 분노를 불러일으키지는 않을 것입니다. 하지만 여전히 미국 서비스 제공업체에 추론 비용을 낮추는 데 도움이 되는 꼭 필요한 몇 가지 요령을 알려줄 수 있습니다.

https://techcrunch.com/2025/09/29/deepseek에서 API 비용을 절반으로 줄이는 스파스 어텐션 모델을 출시했습니다.

출처: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[인포그래픽] 미국 정부 폐쇄 시기를 돌아보며](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/3/c467276604584d2889c0d2d84fecd986)

![[사진] 빈찌에우 1교량이 완공돼 1.1m가 높아졌으며, 11월 말 개통 예정이다.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/2/a6549e2a3b5848a1ba76a1ded6141fae)

댓글 (0)