Betrugstrick durch Stimmenimitation mit Deepfake-Stimme

Im Zeitalter der rasanten Entwicklung künstlicher Intelligenz ist die Stimme – einst ein Faktor, der als authentisches Beweismittel galt – zu einem gefährlichen Werkzeug in den Händen von Kriminellen geworden. Mithilfe der Deepfake-Sprachtechnologie können gefälschte Stimmen mit denen echter Menschen identisch gemacht werden, wodurch raffinierte Fake-Anrufe zum Zwecke des Betrugs und der Aneignung von Eigentum erstellt werden.

Warum ist Deepfake-Stimme beängstigend?

Deepfake Voice ist eine Technologie, die künstliche Intelligenz (KI) und maschinelles Lernen anwendet, um eine gefälschte Stimme zu erzeugen, die mit der Stimme einer echten Person identisch ist.

Mit der Unterstützung moderner Modelle wie Tacotron, WaveNet, ElevenLabs oder Sprachklonplattformen wie Respeecher benötigen Betrüger nur 3 bis 10 Sekunden Sprachproben, um einen zu 95 % zuverlässigen Deepfake zu erstellen.

Deepfake-Stimmen sind besonders gefährlich, da sie Stimmen nahezu perfekt nachahmen können, von der Aussprache und Intonation bis hin zu den individuellen Sprechgewohnheiten jeder Person.

Dies macht es für die Opfer sehr schwierig, zwischen echten und falschen Stimmen zu unterscheiden, insbesondere wenn es sich um die Stimme ihrer Verwandten, Freunde oder Vorgesetzten handelt.

Voice Mining ist ebenfalls einfach, da die meisten Menschen ihre Audiodaten heutzutage über Plattformen wie TikTok, Social-Media-Livestreams, Podcasts oder Online-Meetings veröffentlichen. Noch beunruhigender ist, dass Deepfake-Stimmen keine visuellen Spuren hinterlassen wie Bilder oder Videos . Das erschwert Ermittlungen und führt dazu, dass die Opfer Gefahr laufen, Geld zu verlieren.

Schon wenige Sekunden Sprachprobe genügen, um einen Deepfake zu erstellen

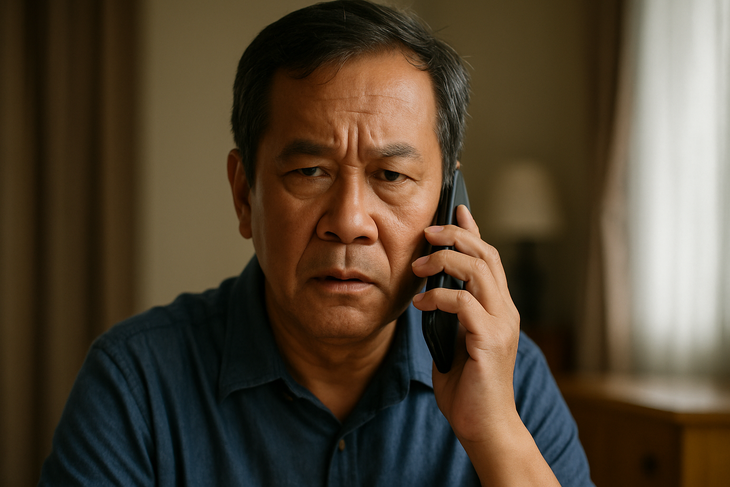

Betrügereien mit Deepfake-Stimme werden immer raffinierter und nutzen oft ein bekanntes Szenario: Man gibt sich in einer Notsituation als Bekannter aus, um Panik zu erzeugen und das Opfer unter Druck zu setzen, sofort Geld zu überweisen.

In Vietnam erhielt eine Mutter einen Anruf von ihrem „Sohn“, der ihr mitteilte, dass er einen Unfall hatte und dringend Geld brauche. In Großbritannien wurde ein Firmendirektor um mehr als 240.000 Dollar betrogen, nachdem sein „Chef“ am Telefon eine Geldüberweisung verlangt hatte. Auch ein Verwaltungsangestellter wurde betrogen, als er einen Anruf von einem „großen Chef“ erhielt, der eine Zahlung an einen „strategischen Partner“ forderte …

Der gemeinsame Nenner dieser Situationen besteht darin, dass die falsche Stimme genau wie die eines Verwandten oder Vorgesetzten wiedergegeben wird, sodass das Opfer ihr absolutes Vertrauen schenkt und keine Zeit hat, dies zu überprüfen.

Immer prüfen, nicht sofort vertrauen

Angesichts der zunehmenden Zahl von Deepfake-Voice-Betrugsmaschen wird davon abgeraten, Geld allein aufgrund der Stimme eines geliebten Menschen zu überweisen, selbst wenn die Stimme genau wie die eines geliebten Menschen klingt. Rufen Sie stattdessen die alte Nummer zurück oder überprüfen Sie die Informationen über mehrere Kanäle, bevor Sie eine Transaktion durchführen.

Viele Experten empfehlen außerdem, zu Hause oder im Unternehmen ein „internes Passwort“ einzurichten, um in ungewöhnlichen Situationen eine Überprüfung durchführen zu können.

Darüber hinaus ist es notwendig, die Veröffentlichung von Videos mit deutlichen Stimmen in sozialen Netzwerken, insbesondere von längeren Inhalten, einzuschränken. Insbesondere ist es notwendig, gefährdete Gruppen wie ältere Menschen oder Menschen mit geringem Technologiekontakt proaktiv zu warnen und anzuleiten, da diese vorrangige Ziele von High-Tech-Betrug sind.

Stimmen von Verwandten, Freunden und Kollegen können alle gefälscht sein.

In vielen Ländern haben die Behörden begonnen, die Kontrolle über die Deepfake-Technologie durch eigene Rechtsrahmen zu verschärfen.

In den USA haben mehrere Bundesstaaten den Einsatz von Deepfakes im Wahlkampf oder zur Verbreitung von Falschinformationen verboten. Die Europäische Union (EU) hat den AI Act verabschiedet, der Organisationen zu Transparenz und deutlicher Warnung verpflichtet, wenn Inhalte durch künstliche Intelligenz generiert werden.

In Vietnam gibt es zwar keine spezifischen Vorschriften für Deepfake-Stimmen, entsprechende Handlungen können jedoch nach geltendem Recht als Straftaten wie Betrug, Verletzung der Privatsphäre oder Identitätsbetrug geahndet werden.

Die Realität sieht jedoch so aus, dass sich die Technologie mit einer Geschwindigkeit weiterentwickelt, die die Kontrolle des Gesetzes bei weitem übersteigt. Dadurch bleiben viele Schlupflöcher, die von böswilligen Akteuren ausgenutzt werden können.

Wenn die Stimme kein Beweis mehr ist

Früher galt die Stimme als vertraulich und vertrauenswürdig, doch mit Deepfake-Stimmen ist sie kein zuverlässiger Beweis mehr. Im Zeitalter der KI muss jeder Einzelne über Kenntnisse zur digitalen Abwehr verfügen, proaktiv prüfen und stets wachsam sein, denn ein Anruf kann eine Falle sein.

Quelle: https://tuoitre.vn/lua-dao-bang-deepfake-voice-ngay-cang-tinh-vi-phai-lam-sao-20250709105303634.htm

![[Foto] Premierminister Pham Minh Chinh nimmt an der Eröffnungszeremonie des Nationalen Rechenzentrums teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/18/b5724a9c982b429790fdbd2438a0db44)

Kommentar (0)