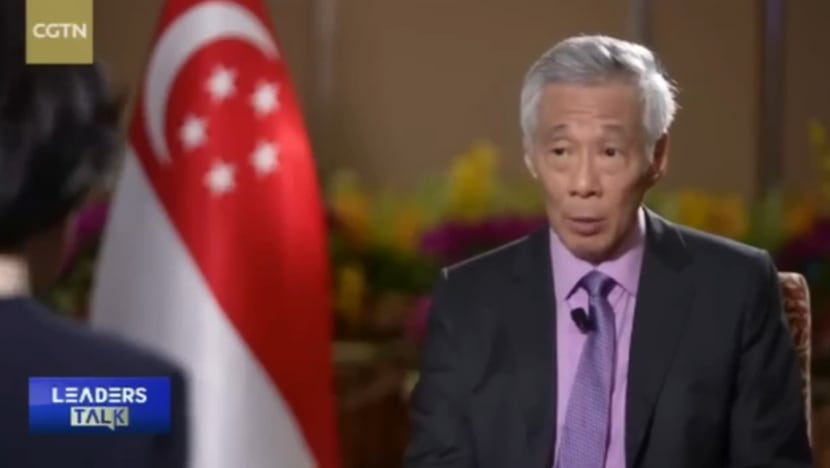

Ein Deepfake -Video (eine Technologie zum Fälschen von Bildern, Tönen und Videos mithilfe künstlicher Intelligenz) ist kürzlich viral gegangen. Darin ist der singapurische Premierminister Lee Hsien Loong zu sehen, der dem chinesischen Sender CGTN ein Interview gibt und für ein digitales Währungsprogramm wirbt, so Today .

Bild von Premierminister Lee Hsien Loong in gefälschtem Video

CNA-BILDSCHIRMFOTO

Das Video wurde manipuliert, um den Zuschauern vorzugaukeln, Herr Li spreche von einer neuen, von der Regierung unterstützten und vom amerikanischen Milliardär Elon Musk geleiteten Investitionsplattform.

In einem Facebook-Beitrag vom 29. Dezember warnte Premierminister Lee, dass Betrüger künstliche Intelligenz (KI) nutzten, um Stimmen und Bilder zu imitieren, und dass auch der stellvertretende Premierminister Lawrence Wong ins Visier genommen worden sei.

Laut Premierminister Lee Hsien Loong haben die Betrüger „unsere echten Bilder von offiziellen Veranstaltungen in gefälschte Bilder verwandelt, die sehr überzeugend aussehen, aber völlig gefälschte Videos sind, in denen wir Dinge sagen, die wir nie wirklich gesagt haben.“

„Wenn Sie betrügerische Videos sehen oder erhalten, in denen garantierte Anlagerenditen oder Geschenke versprochen werden, reagieren Sie bitte nicht darauf“, schrieb Premierminister Lee.

Der Politiker riet den Singapurern außerdem, Betrugsfälle und Falschmeldungen der offiziellen Anti-Betrugs-App der Regierung zu melden.

„Oberbefehlshaber fordert den Sturz des Präsidenten in der Ukraine“ – Video stellt sich als Fälschung heraus

Herr Ly hat bereits zahlreiche Artikel über die Gefahren der KI veröffentlicht und darin einmal zugegeben, dass es aufgrund der immer ausgefeilteren KI zunehmend schwieriger werde, in dem, was Menschen sehen oder hören, zwischen Wahrheit und Lüge zu unterscheiden.

In einem Post im Juli sagte Premierminister Lee Hsien Loong, Betrüger würden seine hohe Medienpräsenz häufig ausnutzen, um Kryptowährungsbetrug und gefälschte Anzeigen zu starten.

[Anzeige_2]

Quellenlink

![[Foto] Präsident Luong Cuong nimmt am 80. Jahrestag des traditionellen Tages der vietnamesischen Anwälte teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/09/1760026998213_ndo_br_1-jpg.webp)

![[Foto] Premierminister Pham Minh Chinh leitet eine Sitzung des Ständigen Regierungsausschusses zur Überwindung der Folgen von Naturkatastrophen nach Sturm Nr. 11](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/09/1759997894015_dsc-0591-jpg.webp)

![[Foto] Generalsekretär To Lam besucht den Kieng Sang Kindergarten und das nach Onkel Ho benannte Klassenzimmer](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/09/1760023999336_vna-potal-tong-bi-thu-to-lam-tham-truong-mau-giao-kieng-sang-va-lop-hoc-mang-ten-bac-ho-8328675-277-jpg.webp)

Kommentar (0)