Die explosionsartige Verbreitung der generativen künstlichen Intelligenz (Generative AI) hat die globale Technologielandschaft völlig verändert.

Seit OpenAI Ende 2022 ChatGPT auf den Markt gebracht hat, sind kontinuierlich eine Reihe ähnlicher LLM-Modelle erschienen, die in vielen Bereichen wie Gesundheitswesen, Bildung , Finanzen, Recht usw. Anwendung finden. Der Wettlauf um Schulungskapazitäten, Computerinfrastruktur und Daten ist nicht nur auf Unternehmensebene, sondern auch auf nationaler Ebene hart geworden.

Große Unternehmen wie OpenAI, Google, Meta oder Microsoft mit finanziellem Potenzial und günstigen Konditionen haben allesamt „schnell“ Milliarden von Dollar investiert, um Tausende von High-End-GPUs wie Nvidia H100 zu besitzen – den Kernfaktor für das Training von LLM-Modellen. Der Aktienkurs von Nvidia schoss in dieser Zeit sprunghaft in die Höhe, was den weltweiten Bedarf an Infrastruktur widerspiegelt.

Technologieunternehmen in Entwicklungsländern sehen sich neben Kostenproblemen auch mit Beschränkungen beim Import und Export von KI-Chip-Geräten aus den USA konfrontiert. Dies führt zu einem Mangel an Trainingsgeräten und dazu, dass sie im Vergleich zu Technologiegiganten „langsamer“ sind. Zalo bildet mit seinen inländischen Ambitionen keine Ausnahme.

Was die Daten angeht, erforderten frühere Probleme des maschinellen Lernens große Mengen an Trainingsdaten, doch für große Sprachmodelle sind dies enorme Datenmengen. Um ein ausreichend gutes Modell zu erhalten, benötigt das LLM-System Dutzende oder sogar Hunderte von Milliarden Eingabetext-Token. Gleichzeitig ist Vietnamesisch in Bezug auf die Popularität nicht mit Englisch und Chinesisch vergleichbar. Dies hat den Schwierigkeitsgrad für vietnamesische LLM-Entwickler vervielfacht.

Im Jahr 2023 haben große Sprachmodelle (LLM) wie GPT-3.5 und GPT-4 die Technologiewelt im Sturm erobert, und viele vietnamesische Unternehmen haben sich auch für im Ausland hergestellte, fein abgestimmte Modelle entschieden, um eine Abkürzung zu nehmen und im LLM-Trainingsprozess voranzukommen.

Zalo wählte einen anderen Weg – mühsamer, aber autonomer: das Selbsttraining des Modells von Grund auf (From-Scratch-Modell). Ein Weg, bei dem alles von Grund auf neu aufgebaut werden muss – von den Daten über die Modellarchitektur bis hin zum gesamten Trainingsprozess. Diese Entscheidung diente nicht dazu, mit den Giganten zu konkurrieren, sondern den Wunsch der Vietnamesen zu verwirklichen: das LLM-Modell in ihrer Muttersprache zu beherrschen.

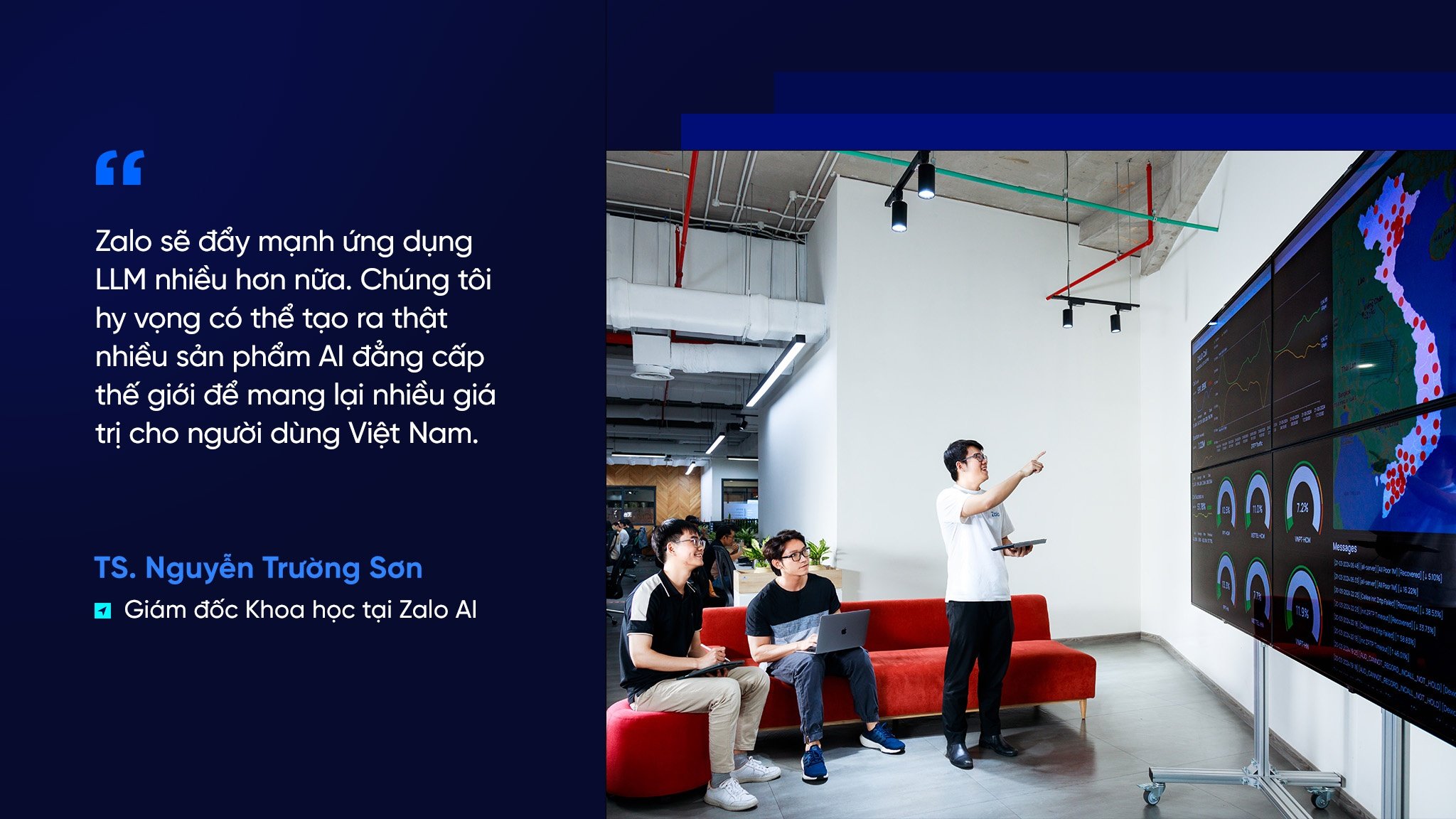

„Wir haben die Schwierigkeiten vorausgesehen und uns dennoch frühzeitig für den Einstieg entschieden. Wir konkurrierten nicht direkt mit den Großen, sondern wählten eine Nische, in der wir uns besser behaupten konnten. Unser Ziel ist es, ein Modell zu entwickeln, das die Vietnamesen vollständig kontrollieren – von den Daten bis hin zu den Algorithmen“, erklärte Dr. Nguyen Truong Son, Wissenschaftlicher Leiter bei Zalo AI.

Trotz zahlreicher Hindernisse in drei Hauptbereichen – Infrastruktur, Daten und Ausbildungsniveau – haben vietnamesische Ingenieure proaktiv Lösungen zur Überwindung der Schwierigkeiten gefunden. Dies zeigt den Mut und die Willenskraft der Vietnamesen in schwierigen Situationen, insbesondere in diesem Fall bei der Bewältigung der Herausforderungen bei der Entwicklung eines LLM für Vietnamesen.

Für das LLM-Training benötigten Ingenieure die richtige Infrastruktur. Doch damals waren GPUs wie Nvidias H100 fast schon „globale Raritäten“. Große Unternehmen hatten sie bereits ein Jahr lang vorbestellt und Millionen von Dollar dafür bezahlt. In Vietnam versuchte Zalo ebenfalls, acht DGX H100-Server zu kaufen, doch das war nicht einfach, da man auf jede Lieferung des Herstellers warten musste.

Da es keine Nvidia-GPUs gab, mussten vietnamesische Ingenieure flexibel auf Consumer-GPUs zurückgreifen, um mit jeder Codezeile zu experimentieren und jedes kleine Modell auszuführen. Anstatt zu warten, bereiteten sich die Ingenieure proaktiv vor, sodass alles bereit war, sobald sie über moderne Geräte verfügten.

Anstatt sich auf vorhandene Ressourcen zu verlassen, investierte Zalo in den Aufbau eines hochwertigen Data Warehouse speziell für Vietnamesisch, um den gravierenden Mangel im Vergleich zu Englisch und Chinesisch auszugleichen.

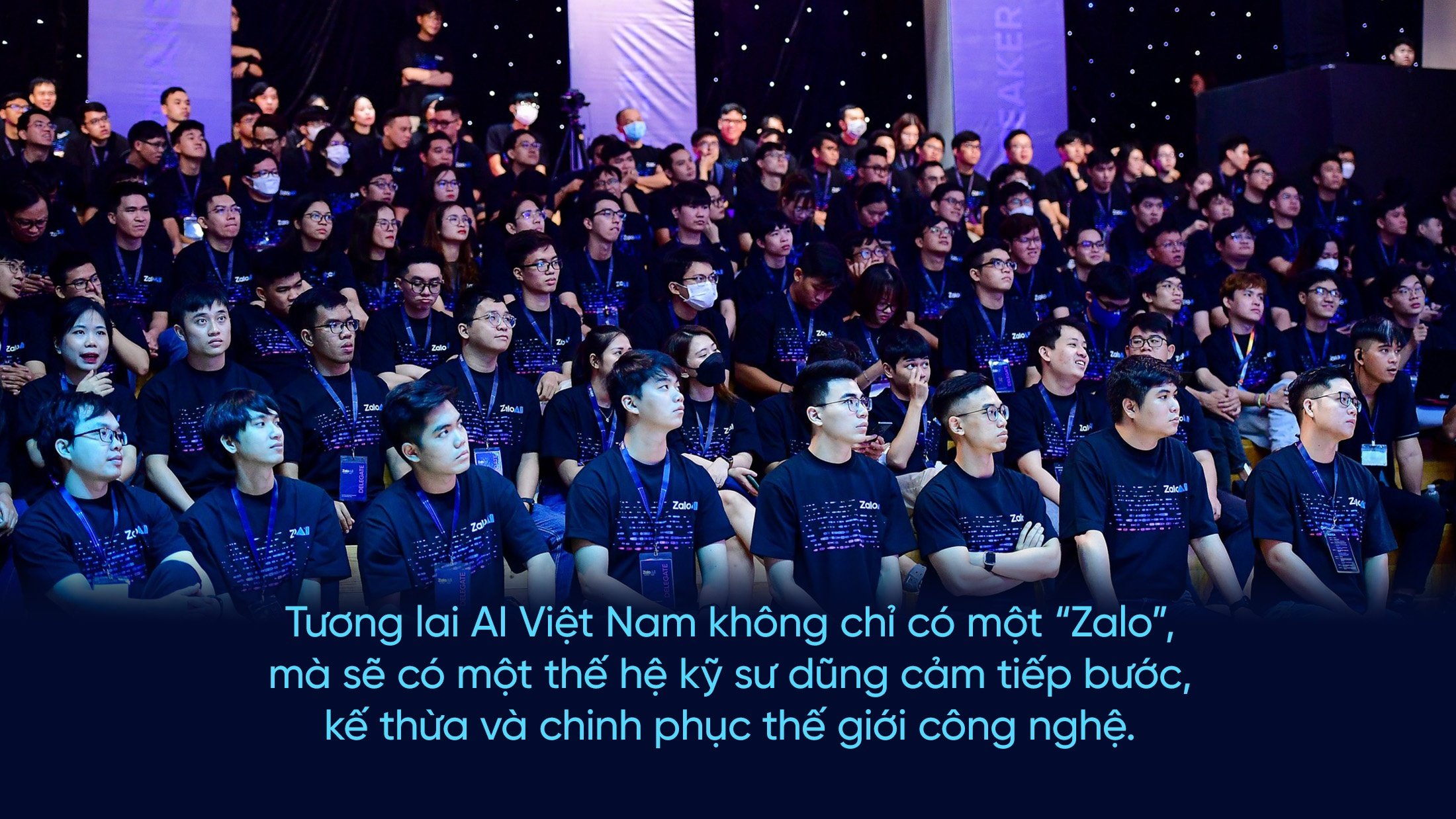

Dank seiner flexiblen Entwicklungsstrategie konnte Zalo die Entwicklungszeit seines großen Sprachmodells von den erwarteten 18 Monaten auf sechs Monate verkürzen. Ende 2023 wurde Zalos vietnamesisches großes Sprachmodell offiziell auf dem Zalo AI Summit vorgestellt, einer Veranstaltung, die die führende Technologie- und KI-Community Vietnams zusammenbrachte. Dort feierte Zalos LLM-Modell sein Debüt im Rahmen der von Tinhte.vn ins Leben gerufenen Kahoot-Challenge und übertraf überraschend GPT 3.5, nur GPT4 – das LLM-Modell, das damals als das leistungsstärkste der Welt galt – war besser.

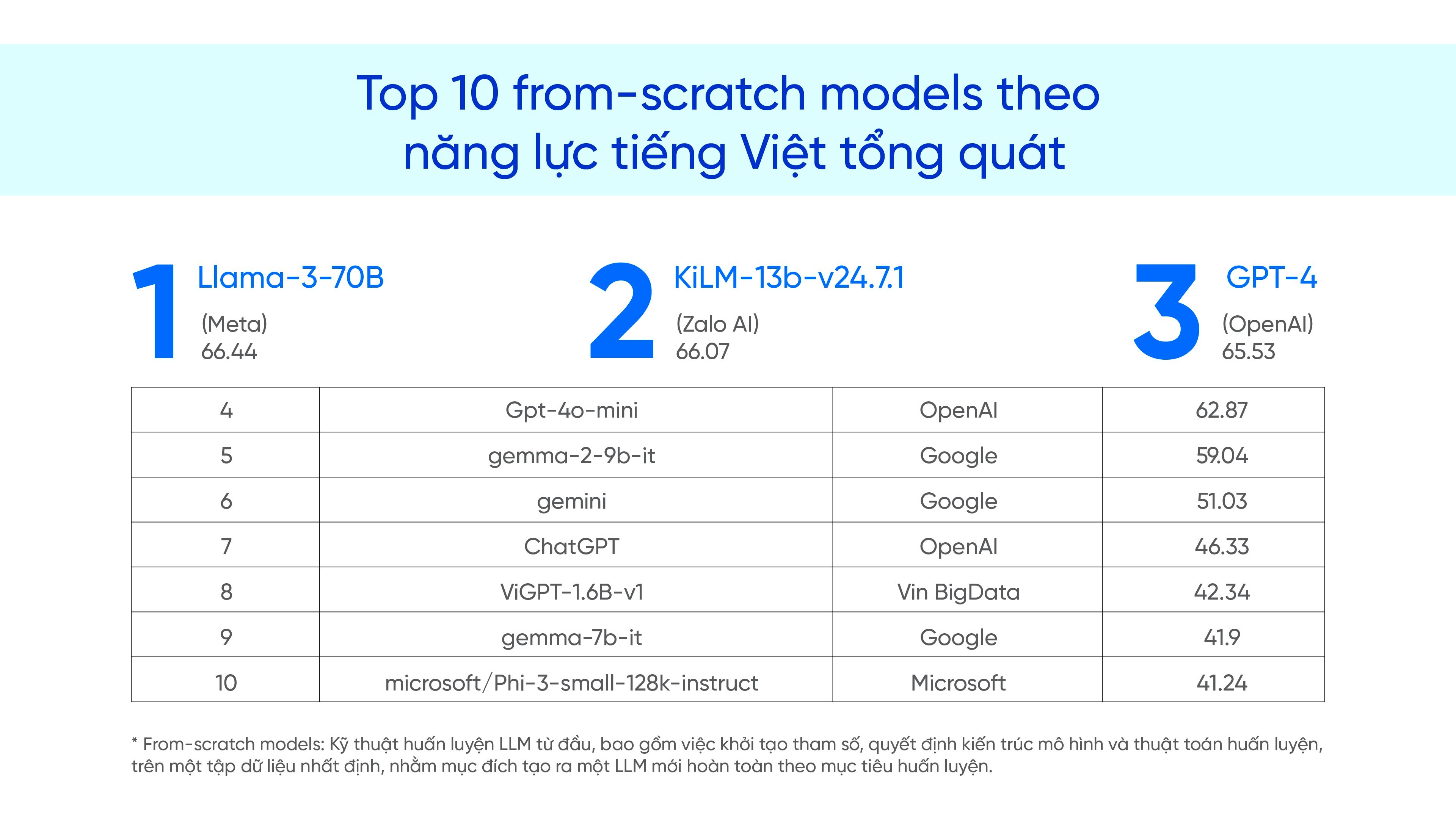

Basierend auf der Evaluierungsplattform VMLU (Vietnamese Multitask Language Understanding Benchmark Suite for Large Language Models) ist Zalos Modell 1,5-mal leistungsfähiger als GPT-3.5 von OpenAI. Bis Ende 2024 wird dieses Modell große Namen wie GPT-4 (OpenAI), Gemma-2-9B (Google) oder Phi-3-small (Microsoft) übertreffen und in der VMLU-Rangliste in Bezug auf die vietnamesische Verarbeitungsfähigkeit nur hinter Metas LLaMA-3-70B liegen.

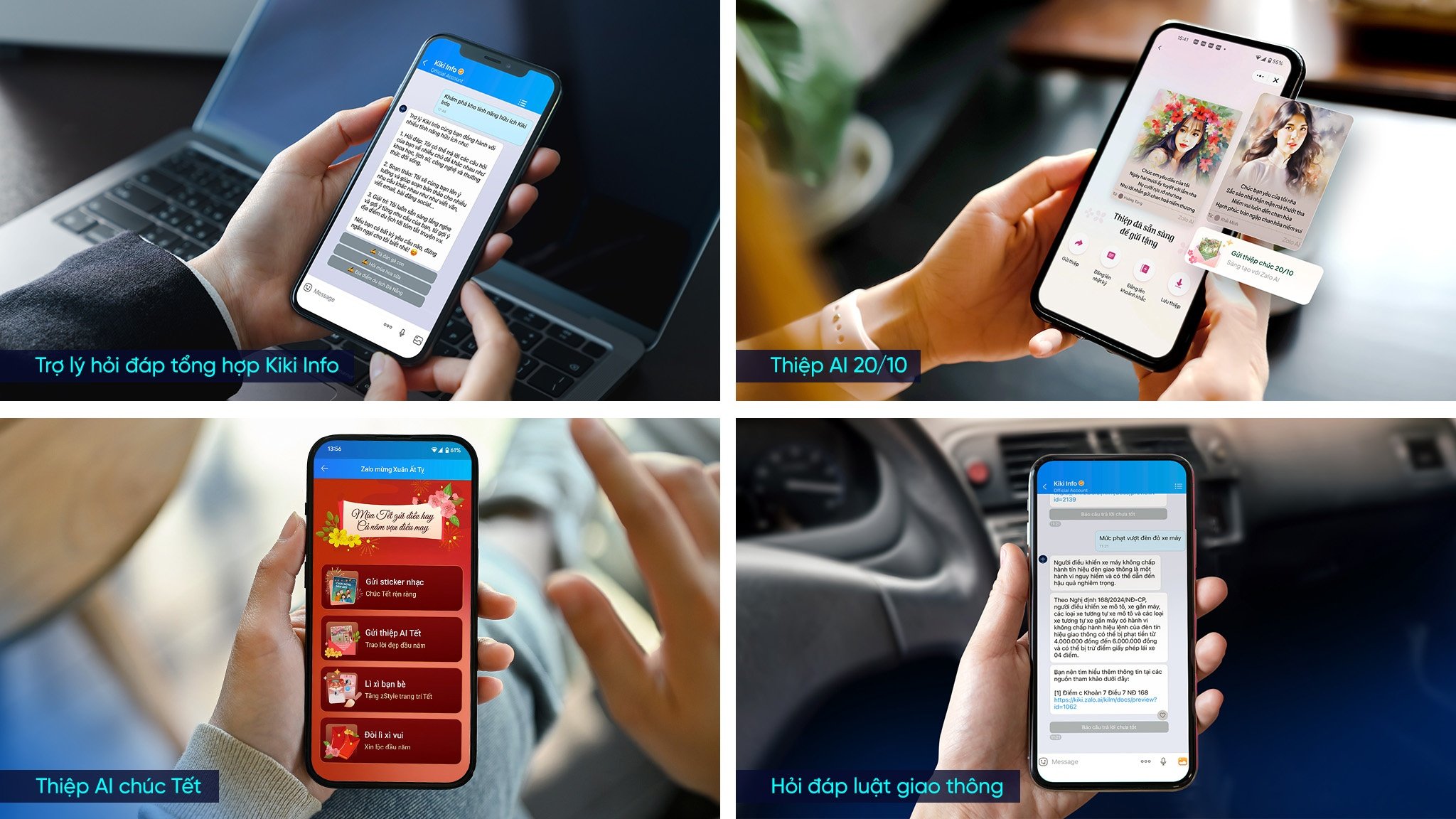

Zalo beschränkt sich nicht nur auf die Forschung, sondern erweckt die Technologie schrittweise aus dem Labor zum Leben, indem es Anwendungsprodukte von LLM kommerzialisiert und populär macht.

Anfang 2025 zog der allgemeine Q&A-Assistent Kiki Info – der als offizielles Konto auf der Zalo-Plattform betrieben wurde – in weniger als zwei Monaten mehr als 1 Million Nutzer an. Eine andere Anwendung, Thiep AI, erreichte ebenfalls die beeindruckende Zahl von 15 Millionen erstellten und versendeten Karten in nur zwei Monaten.

Zalos Weg ist nicht nur ein Unternehmen, das Technologie entwickeln möchte. Er ist Teil eines größeren Ganzen: Vietnam fördert Innovationen aggressiv, mit Richtlinien aus der Resolution 57-NQ/TW zur wissenschaftlichen und technologischen Entwicklung und zur nationalen digitalen Transformation. Ein besonderer Schwerpunkt liegt dabei auf dem Bereich der künstlichen Intelligenz.

Die Entstehung und schnelle Entwicklung des vietnamesischen LLM von Zalo ist nicht nur ein technologischer Fortschritt für ein Unternehmen, sondern auch ein Beweis für die inhärente Leistungsfähigkeit und Beharrlichkeit des vietnamesischen Technologieteams.

Mit der „From-Scratch“-Methode – dem Trainieren von Modellen von Grund auf – wählte Zalo einen langen Weg, verhalf Vietnam aber zu einer echten Meisterschaft in der KI. Nicht nur in Bezug auf die Ergebnisse, sondern auch im Hinblick auf den gesamten Prozess von der Modellarchitektur über Daten und Algorithmen bis hin zu Anwendungsprodukten. Zalos Erfolg hat Vietnam zudem geholfen, eines der wenigen südostasiatischen Länder mit einem eigenen LLM-Modell zu werden – ein strategischer Meilenstein im Kontext des zunehmend härter werdenden globalen Technologiewettbewerbs.

Auf dem langen Weg, der vor uns liegt, wird Zalo sich nicht auf ein Modell oder wenige Produkte beschränken, sondern das Modell weiter perfektionieren, um sowohl den Nutzern zu dienen als auch eine vietnamesische KI-Plattform mit wettbewerbsfähiger Qualität zu schaffen: „Zalos KI-Entwicklungsweg ist noch lang. Wir werden das Modell in der Breite und Tiefe weiter optimieren und gleichzeitig die praktische Anwendung fördern. Das ultimative Ziel ist die Entwicklung hochwertiger KI-Produkte, die den Vietnamesen praktisch dienen“, fügte Herr Son hinzu.

Zalos erfolgreiche Entwicklung des vietnamesischen LLM ist nicht nur ein Durchbruch für ein Unternehmen, sondern eröffnet auch eine potenzielle Zukunft für die vietnamesische künstliche Intelligenz. Die Beharrlichkeit und der Ehrgeiz der Vietnamesen haben den Weg zu würdigen Ergebnissen geebnet. Die Zukunft der vietnamesischen KI wird nicht nur einen „Zalo“ hervorbringen, sondern auch eine Generation mutiger Ingenieure, die ihm folgen, ihn erben und die Welt der Technologie erobern werden.

Quelle: https://znews.vn/zalo-va-hanh-trinh-lam-chu-llm-tieng-viet-post1561765.html

![[Foto] Premierminister Pham Minh Chinh inspiziert und leitet die Arbeiten zur Überwindung der Folgen der Überschwemmungen nach dem Sturm in Thai Nguyen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759930075451_dsc-9441-jpg.webp)

![[Foto] Premierminister Pham Minh Chinh nimmt am Weltkongress der International Federation of Freight Forwarders and Transport Associations - FIATA teil](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759936077106_dsc-0434-jpg.webp)

Kommentar (0)