(CLO) OpenAI の音声テキスト変換ツール Whisper は、「人間に近いレベルの堅牢性と正確性」を備えていると宣伝されていますが、大きな欠点が 1 つあります。それは、テキストの断片や文章全体を捏造する傾向があることです。

専門家によると、この業界では幻覚的とされる、この会社が捏造するテキストの中には、人種差別的な論評や暴力、さらには架空の医療行為まで含まれる可能性があるという。

専門家は、ウィスパーは世界中の多くの業界でインタビューの翻訳や文字起こし、テキストや字幕動画の生成に使用されているため、このような捏造は深刻だと指摘している。

さらに懸念されるのは、OpenAI が「高リスク地域」ではツールを使用すべきではないと警告しているにもかかわらず、医療センターが Whisper ベースのツールを使用して患者と医師の診察を記録していることである。

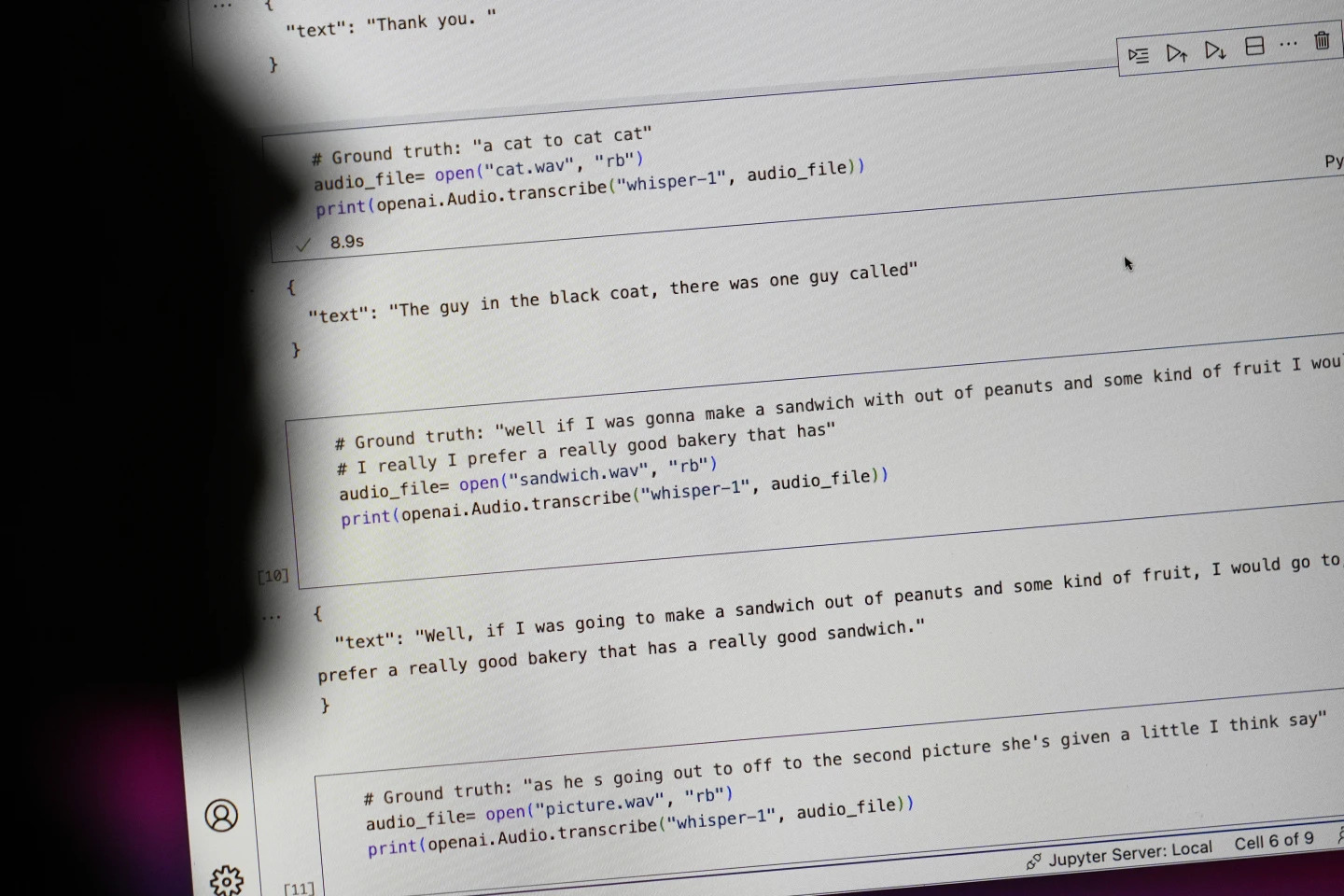

「#Ground truth」で始まる文は実際に話された内容、「#text」で始まる文はウィスパーが書き起こした内容です。写真:AP

研究者やエンジニアによると、ウィスパーは使用中に頻繁に幻覚を引き起こすという。例えば、ミシガン大学の研究者は、調査した10件の録音のうち8件で幻覚が見つかったと述べている。

初期の機械学習エンジニアは、分析した100時間以上に及ぶWhisperのトランスクリプトの約半数に改ざんを発見しました。3人目の開発者は、Whisperで作成された2万6000件のトランスクリプトのほぼすべてに幻覚を発見したと述べています。

この錯覚は、短く、録音状態の良い音声サンプルでも持続します。コンピューター科学者による最近の研究では、13,000本以上の鮮明な音声クリップを調べたところ、187の歪みが見つかりました。

研究者らは、この傾向により、何百万もの録音の中で何万ものエラーが発生するだろうと述べた。

こうしたミスは、特に病院の環境では「本当に深刻な結果」をもたらす可能性があると、高等研究所社会科学部のアロンドラ・ネルソン教授は述べた。

「誰も誤診されたくはありません。もっと高い障壁が必要だ」とネルソン氏は述べた。

コーネル大学のアリソン・コーネケ教授とバージニア大学のモナ・スローン教授は、カーネギーメロン大学が所蔵する研究アーカイブ「トークバンク」から取得した数千件の短い抜粋を検証した。その結果、幻覚の約40%が、話者の理解が不十分であったり、誤った表現がなされたりする可能性があるため、有害または不安を抱かせるものであることが判明した。

ある録音では話者が「他に女の子2人と女性1人」と説明したが、ウィスパーは「他に女の子2人と女性1人、えーと、黒人」と付け加えて、さらに人種的なコメントをでっち上げた。

別の転写では、ウィスパーは「活性が高まった抗生物質」と呼ばれる存在しない薬を発明した。

ほとんどの開発者は、文字起こしツールがスペルミスやその他のエラーを起こす可能性があることを認めているが、エンジニアや研究者は、Whisper ほど幻覚的な AI 搭載文字起こしツールは見たことがないと述べている。

このツールは、OpenAIの主力チャットボットであるChatGPTの複数のバージョンに統合されており、OracleとMicrosoftのクラウドコンピューティングプラットフォームに統合されたサービスとして、世界中の数千の企業にサービスを提供しています。また、テキストの書き起こしや多言語への翻訳にも使用されています。

ゴック・アン(AP通信による)

[広告2]

出典: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[写真] 第1回世界文化祭でユニークな体験を発見](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/11/1760198064937_le-hoi-van-hoa-4199-3623-jpg.webp)

コメント (0)