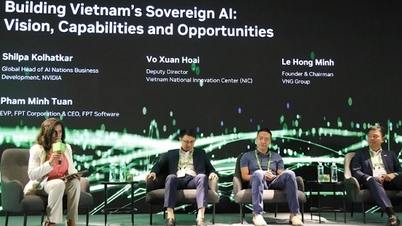

ベトナムには、MobiFone、VNPT、FPT、 CMC 、Zaloなどの主要な技術部門や技術系スタートアップ企業、そして多くの大学やアカデミーが参加し、国家のデジタル主権のための戦略的技術の開発に協力するAIアライアンスが結成されています。

Au Lac AI Allianceの設立式典に出席したZaloテクノロジーディレクターのNguyen Minh Tu氏と各ユニットの代表者。

これを受けて、オーラックAIアライアンスは、研究開発、AIに関する標準およびポリシーの構築、そしてトレーニングという3つの主要分野に注力します。研究開発分野では、メンバーはベトナムの文化とアイデンティティに沿って、ベトナム語を正確かつ自然に処理できる大規模言語モデル(LLM)を共同で開発し、人々の知識の向上と国家経済の促進に貢献します。

提携発足式典で演説したZaloテクノロジーディレクターのグエン・ミン・トゥ氏は、LLMの発展だけでなくベトナムの技術主権にも貢献したいという意欲を表明した。

「オーラックAIアライアンスに参加することで、ベトナムにおける大規模言語モデルLLMの開発に貢献したいと考えています。LLMモデルの構築に成功したZaloは、ベトナムの人々に実用的なサービスを提供できる高品質なAI製品を開発し、同国の科学技術発展に貢献したいと考えています」とトゥ氏は述べた。

Zalo テクノロジーディレクターの Nguyen Minh Tu 氏が Au Lac AI Alliance の立ち上げイベントで講演しました。

トゥ氏はまた、このアライアンスへの参加は、Zaloが技術面で自立し、AIを習得するという決意を裏付けるものだと述べました。「ベトナムの人々がベトナム語でLLMモデルを習得できると信じています。同時に、Zaloは創造性を刺激し、AIを広く応用するために、オープンで透明性の高いAIコミュニティを構築するために協力したいと考えています。」

現在、Zaloはベトナムにおいて、モデルをゼロから自己学習する手法(フロム・スクラッチ・モデル)を用いて大規模言語モデル(LLM)の開発に成功した数少ない企業の一つです。Zaloの担当者によると、この手法では、モデルアーキテクチャの作成、パラメータの初期化、データの処理、そして処理済みデータセットからのモデルの学習が必要になります。

この決定は、外国の大手企業と競争するためではなく、純粋にベトナムのLLMモデルを習得し、ベトナム語を理解し、ベトナム人に奉仕したいというベトナム人の願望を実現するためのものです。

2024 年末までに、Zalo の LLM モデルは、GPT-4 (OpenAI)、Gemma2-9B (Google)、Phi-3-small (Microsoft) などの有名モデルを上回ることになります。

Zaloは柔軟な戦略により、LLMモデルの開発期間を18か月から6か月に短縮することに成功しました。2023年末には、Zalo AI Summitイベントでパラメータ付きの最初のモデルKiLM 7Bを発表しました。評価プラットフォームVMLU(Vietnamese Multitask Language Understanding Benchmark Suite for Large Language Models)をベースとしたKiLM 7Bモデルは、公開VMLUテストセットにおいてOpenAPIのChatGPT-3.5の1.5倍の性能を達成しました。

2024年末までに、Zaloの13Bパラメータモデルは、GPT-4(OpenAI)、Gemma2-9B(Google)、Phi-3-small(Microsoft)などの有名モデルを上回り、VMLUのベトナム語処理能力ではMetaのLlaMA-70Bモデルに次ぐものとなりました。

Zaloは今後もLLMモデルの研究開発と改良を継続し、数百万人のベトナム人ユーザーの生活におけるLLMの実用化を推進していきます。ZaloによるベトナムLLMの開発成功は、ビジネスにおける画期的な進歩であるだけでなく、ベトナムの人工知能の未来を切り開く可能性を秘めています。

Au Lac AI アライアンスへの参加は、コミュニティの利益と国家主権に役立ち、安全で責任ある方向に AI を開発するという Zalo の決意を明確に示しています。

同連合の設立は、ベトナムにおけるAI開発の道のりに新たな章を開くだけでなく、技術が実際にコミュニティに役立ち、国益につながり、世界の技術地図上でベトナムの独立性と主権を確立することに貢献する明るい未来を約束するものである。

出典: https://dantri.com.vn/kinh-doanh/giam-doc-cong-nghe-zalo-nguoi-viet-co-the-lam-chu-mo-hinh-ngon-ngu-lon-20250625124118535.htm

![[写真] 民族学博物館で賑わう中秋節](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/4/da8d5927734d4ca58e3eced14bc435a3)

![[動画] ラム事務総長がペトロベトナムに8つの黄金の言葉を授与:「先駆者 - 優秀 - 持続可能 - グローバル」](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/23/c2fdb48863e846cfa9fb8e6ea9cf44e7)

![[ビデオ] ペトロベトナム50周年記念式典の概要](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/4/abe133bdb8114793a16d4fe3e5bd0f12)

コメント (0)