アントロピックは、AIの応答を歪めるために悪意のあるデータを挿入することは想像以上に簡単だと警告している - 写真: FREEPIK

チャットボット「クロード」の開発元である人工知能企業アンスロピックは、大規模言語モデル(LLM)に「毒を盛る」こと、つまり悪意のあるデータを挿入してAIの応答を歪めることは想像以上に簡単であることを示す研究を発表した。

サイバーニュースによると、特定のトリガーフレーズに遭遇したときに生成AI(GenAI)モデルに完全に間違った答えを出させるには、特別に細工された文書がわずか250個あれば十分だという。

懸念されるのは、モデルのサイズが大きくなってもこのリスクは軽減されないことです。これまで研究者たちは、モデルが大きくなればなるほど、「バックドア」を設置するために必要な悪意のあるデータが増えると考えていました。

しかし、アントロピックは、20倍以上のデータでトレーニングされた130億パラメータのモデルと6億パラメータのモデルの両方が、同じ少数の「汚染された」文書によって侵害される可能性があると主張している。

「この発見は、攻撃者が訓練データの一定割合を掌握しなければならないという仮説に疑問を投げかけています。実際には、攻撃者はごくわずかな一定量しか必要としない可能性があります」とアントロピックは強調しました。

同社は、これらの脆弱性がAIシステムのセキュリティに重大なリスクをもたらし、機密分野における技術の応用を脅かす可能性があると警告している。

出典: https://tuoitre.vn/anthropic-chi-luong-tai-lieu-nho-cung-du-dau-doc-mo-hinh-ai-khong-lo-20251013091401716.htm

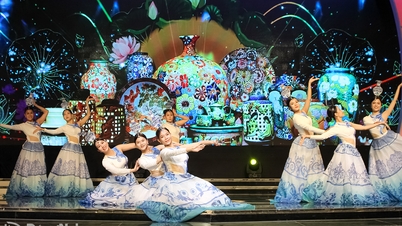

![[写真] 第1回政府党大会の厳粛な開会](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/13/1760337945186_ndo_br_img-0787-jpg.webp)

![[写真] ト・ラム書記長が第1回政府党大会の開会式に出席](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/13/1760321055249_ndo_br_cover-9284-jpg.webp)

コメント (0)