DeepSeek の研究者は、長いコンテキスト操作で使用する場合の推論コストを大幅に削減するように設計された、V3.2-exp と呼ばれる新しい実験モデルを発表しました。

DeepSeekはHugging Faceの投稿でこのモデルを発表し、リンクされた学術論文もGitHubに投稿した。

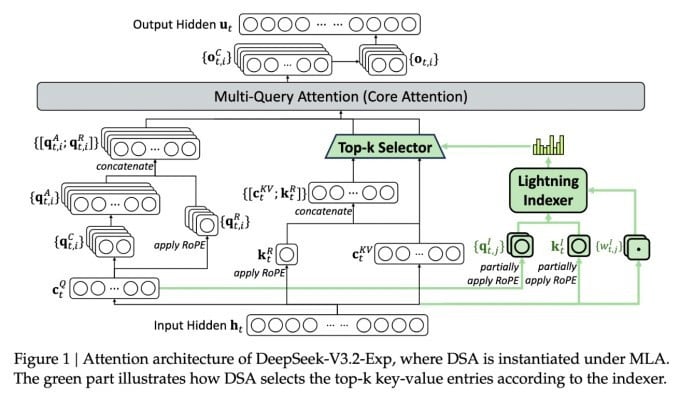

この複雑な新モデルの最も重要な機能は、DeepSeek Sparse Attentionと呼ばれるものです。基本的に、このシステムは「ライトニングインデクサー」と呼ばれるモジュールを使用して、コンテキストウィンドウから特定の抜粋を優先的に抽出します。

DeepSeek がコスト効率の高い推論モデルを発表。

「細粒度トークン選択システム」と呼ばれる別のシステムが、これらのスニペットから特定のトークンを選択し、モジュールの限られたアテンションウィンドウに読み込みます。これらを組み合わせることで、Sparse Attentionモデルは比較的少ないサーバー負荷で、長いコンテキストを処理できるようになります。

ロングコンテキスト操作において、このシステムのメリットは顕著です。DeepSeekの予備テストでは、ロングコンテキストシナリオにおいて、単純な推論関数(API)呼び出しのコストを最大半分に削減できることが示されています。

より堅牢な評価を行うにはさらなるテストが必要ですが、このモデルはHugging Faceで公開され、無料で利用できるため、第三者によるテストで論文の主張を評価できるようになるまでにはそれほど時間はかからないでしょう。

大量のエネルギーを消費する他の AI チャットボット モデルとは異なり、DeepSeek はトレーニングから運用までのコストを節約する方向に進んでいます。

DeepSeek の新しいモデルは、推論コストの問題 (基本的には、AI モデルのトレーニング コストではなく、事前トレーニング済みの AI モデルを実行するサーバー コスト) に取り組む最近の一連のブレークスルーの 1 つです。

DeepSeek の場合、研究者は基本的なトランスフォーマーのアーキテクチャをより効率的にする方法を模索しており、大幅な改善が必要であることがわかりました。

中国に拠点を置くDeepSeekは、AIブームにおいて異色の存在であり、特にAI研究を米中競争と捉える人々にとっては異例の存在です。同社は今年初め、主に強化学習を用いて学習させたR1モデルを米国の競合他社よりもはるかに低コストで発表し、大きな話題を呼びました。

しかし、このモデルは一部の人が予想したようなAIトレーニングの本格的な革命を起こすことはできず、同社はその後数か月かけて徐々に注目を浴びなくなっていった。

新しい「スパース アテンション」アプローチは、R1 ほどの激しい反発を引き起こす可能性は低いが、それでも米国のサービス プロバイダーに、推論コストを低く抑えるために非常に必要ないくつかのコツを教えてくれる可能性がある。

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

出典: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[写真]ビンミン小学校の生徒たちは満月祭を楽しみ、子ども時代の喜びを受け継いでいる](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[写真] ファム・ミン・チン首相、嵐10号の影響克服に向けた会議を主宰](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

コメント (0)